Le web scraping est aujourd’hui une composante stratégique dans de nombreux secteurs, allant de la recherche académique à la veille concurrentielle, en passant par l’e-commerce et le marketing. Il devient indispensable de disposer d’un outil scraping gratuit à vos besoins pour scraper un site efficacement.

Cet article vous accompagnera pour comprendre comment scraper site web gratuit en 2025, mais aussi pour découvrir les meilleures outils pour aspirer un site efficacement, que ce soit pour extraire des images, collecter des données structurées ou automatiser toute cette opération. La maîtrise de ces outils vous permettra d’adopter une démarche optimale dans un environnement numérique en constante évolution.

Transformer les sites web vers Excel, CSV, Google Sheets ou base de données.

Auto-détecter les sites Web et extraire les données sans aucun codage.

Scraper les sites populaires en quelques clics avec les modèles pré-construits.

Ne se trouver jamais bloqué grâce aux proxies IP et à l’API avancée.

Service Cloud pour programmer le scraping de données.

Comment fonctionne les outils de scraping

Le web scraping est le moyen de collecter automatiquement les données depuis des pages web à l’aide d’un robot de scraping, permettant de récupérer les données à grande échelle très rapidement. En même temps, des fonctionnalités supplémentaires comme RegEx ou XPath sont mises en service pour obtenir les données structurées et précises.

Le web scraping gratuit fonctionne comme suit :

Tout d’abord, un robot de scraping simule l’acte de navigation humaine sur le site web. Après qu’on entre l’URL cible, le robot envoie une requête au serveur et récupère les informations dans le fichier HTML.

Ensuite, quand le robot a déjà saisi le code source HTML, il va atteindre la partie où se trouvent les données désirées et les analyser comme il est programmé dans le code de scraping.

À la fin, l’ensemble des données extraites sera nettoyé et structuré en fonction de la configuration du robot. Jusque là, les données sont prêtes à être téléchargées ou exportées dans votre base de données.

Comment choisir un bon outil de scraping

Lorsque vous choisissez un outil de scraping pour scraper un site, plusieurs critères essentiels doivent guider votre décision, surtout si vous recherchez un logiciel de scraping gratuit ou une solution à faible coût.

- La compatibilité du dispositif est fondamentale : certains outils de scraping gratuits supportent uniquement Windows, tandis que d’autres, comme Octoparse, sont aussi disponibles pour Mac ou Linux, voire en mode Cloud. Cela permet de s’adapter à toutes les configurations professionnelles ou personnelles.

- La capacité à gérer un scraper un site entier ou plusieurs pages en masse est un avantage important, notamment pour extraire rapidement des images, des PDF ou tout autre format de fichiers. Des logiciels de scraping gratuits comme Web Scraper ou Data Miner offrent souvent cette fonctionnalité.

- La facilité d’utilisation représente également un critère clé : un bon outil scraping gratuit doit offrir une interface intuitive, un support dans votre langue, idéalement en français, et des tutoriels accessibles. Avec des outils comme Octoparse ou ParseHub, même les débutants peuvent rapidement prendre en main le logiciel.

- L’automatisation est un autre point crucial : vous devez pouvoir gérer la pagination, utiliser des proxies ou des extensions pour lever certains obstacles, et surtout, pouvoir programmer des tâches de scraping répétitives ou en mode auto-start. La gestion multipages en masse et l’intégration avec d’autres outils d’analyse ou bases de données augmentent aussi la productivité.

- Le rapport coût/bénéfice est vital, surtout si vous optez pour un outil de scraping gratuit ou à faible coût. Il faut vérifier si l’outil gratuit offre suffisamment de fonctionnalités pour couvrir vos besoins ou si une version payante apporte un vrai plus — notamment en termes d’automatisation, de vitesse ou de traitement de gros volumes.

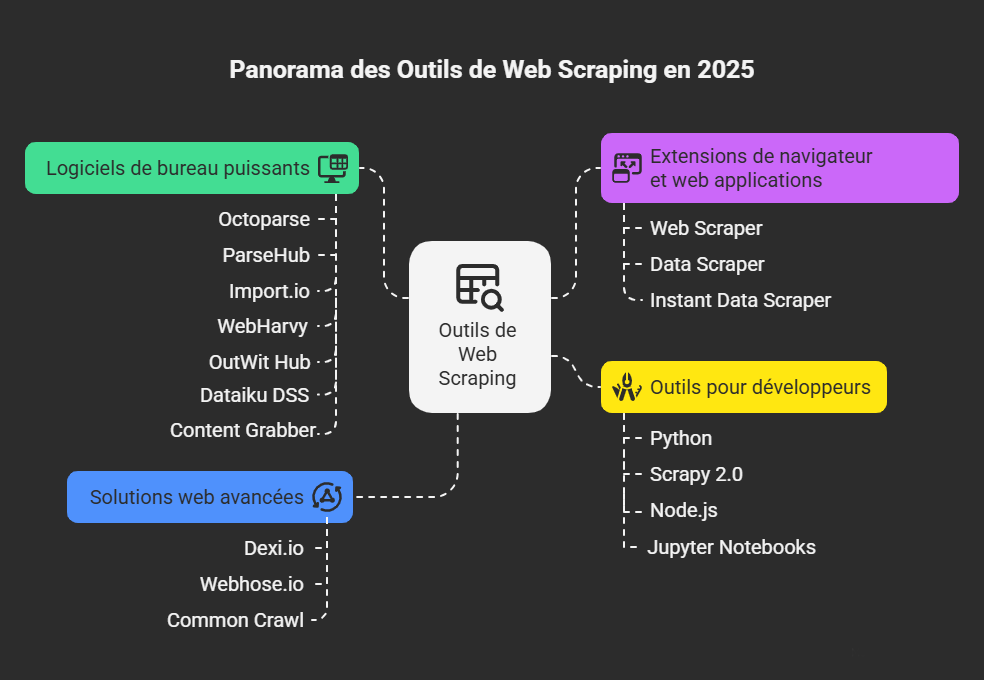

Panorama des outils de scraping en 2025

1. Logiciels de bureau puissants

- Octoparse est souvent considéré comme la référence en matière de scraper un site. Il intègre une IA avancée qui facilite la détection automatique des données, la gestion de la pagination, l’extraction en masse et les modèles prédéfinis du monde entier. Il supporte à la fois une version gratuite accessible à tous, permettant de réaliser du web scraping gratuit, ainsi qu’un service en nuage idéal pour traiter de gros volumes de données.

- ParseHub est un autre logiciel de scraping gratuit très apprécié pour sa simplicité d’utilisation. Il convient parfaitement aux utilisateurs qui n’ont pas de connaissances techniques approfondies, tout en offrant la possibilité d’aspirer un site même avec des pages utilisant AJAX ou JavaScript.

- Import.io est une solution SaaS largement utilisée dans le domaine de l’e-commerce pour la collecte de données à grande échelle. Sa plateforme offre de nombreuses possibilités d’intégration et est reconnue comme un outil scraping gratuit efficace pour automatiser la récupération de données massives.

- WebHarvy se distingue par son interface graphique intuitive, ce qui permet de scraping de données facilement sans programmation. C’est une option intéressante pour ceux qui cherchent un outil simple mais performant.

- OutWit Hub, quant à lui, propose une interface conviviale permettant d’extraire rapidement des données ciblées. Son avantage réside dans sa facilité d’utilisation pour réaliser des scraping gratuits sans une configuration complexe.

- Dataiku DSS est une plateforme de niveau avancé qui combine web scraping et analyse de données. Idéal pour automatiser des traitements complexes et gérer de gros volumes, c’est un outil adapté aux projets professionnels nécessitant une intégration poussée.

- Content Grabber est une solution particulièrement puissante, conçue pour le scraping en masse. Elle est spécialisée dans la collecte de données massives à partir de sites très complexes, en offrant des performances optimales pour les besoins professionnels les plus exigeants.

2. Extensions de navigateur et web applications

- Web Scraper est très populaire pour scraper un site en configurant un sitemap, ce qui permet d’automatiser le processus via le mode cloud. Cette solution est pratique pour ceux qui cherchent un outil scraping gratuit facile à utiliser tout en bénéficiant d’un bon contrôle sur la structure du site.

- Data Scraper est une extension compatible avec Chrome et Firefox, très efficace pour faire du scraping gratuit en quelques clics. Elle est particulièrement adaptée pour scraper un site rapidement, notamment pour extraire des tableaux ou des listes, sans nécessiter de compétences approfondies.

- Instant Data Scraper est une extension Chrome très simple, parfaite pour des opérations rapides. Avec cet outil, vous pouvez copier un site en quelques secondes, sans configuration complexe ni programmation, ce qui en fait un excellent choix si vous cherchez une solution outil scraping gratuite et efficace pour vos besoins immédiats.

3. Outils pour développeurs

- Python (BeautifulSoup, Selenium, Playwright) est une des meilleures options pour ceux qui maîtrisent la programmation. Ces outils permettent de scraper un site avec un contrôle précis sur la récupération des données, tout en restant dans une démarche de web scraping gratuit. Ils offrent une flexibilité exceptionnelle pour automatiser des tâches complexes et personnalisées.

- Scrapy 2.0 est un framework puissant pour réaliser un scraping gratuit à grande échelle. Son architecture modulaire facilite la gestion de pages très structurées ou dynamiques, ce qui en fait un excellent choix si vous souhaitez scraper un site complexe avec précision.

- Node.js (Puppeteer) est une bibliothèque efficace pour scraper un site dynamique, notamment lorsque le contenu est chargé via des scripts JavaScript. Elle permet de simuler un navigateur complet pour extraire toutes sortes de données, idéal pour les experts en web scraping qui cherchent une solution flexible et performante.

- Jupyter Notebooks est une plateforme pratique pour tester rapidement des scripts de web scraping en Python. C’est un excellent environnement pour expérimenter, automatiser des tâches ciblées et peaufiner votre stratégie de scraper un site à votre rythme.

4. Solutions web avancées

- Dexi.io est destiné aux utilisateurs avancés qui ont de bonnes compétences en programmation. Il dispose de trois types de robots que vous pouvez utiliser pour créer une tâche de scraping : Extractor, Crawler et Pipes. Il fournit divers outils qui vous aident à extraire les données plus précisément. Pour les personnes n’ayant aucune compétence en programmation, vous devrez peut-être prendre un certain temps pour vous y habituer avant de créer un robot de Web scraping. Le logiciel gratuit fournit des serveurs proxy Web anonymes pour le Web scraping. Les données extraites seront hébergées sur les serveurs de Dexi.io avant d’être archivées pendant deux semaines, ou vous pouvez directement exporter les données extraites vers des fichiers JSON ou CSV. Il propose des services payants pour la collecte de données en temps réel.

- Webhose.io vous permet d’obtenir des données en temps réel en récupérant des sources en ligne du monde entier dans divers formats propres. Vous pouvez même récupérer des informations sur le Web sombre. Ce web scraper vous permet de récupérer des données dans de nombreuses langues différentes à l’aide de plusieurs filtres et d’exporter des données récupérées aux formats XML, JSON et RSS. Le logiciel gratuit propose un plan d’abonnement gratuit pour vous permettre de faire 1000 requêtes HTTP par mois et des plans d’abonnement payants pour faire plus de requêtes HTTP par mois en fonction de vos besoins de Web scraping.

- Common Crawl représente une ressource en ligne immense, contenant des milliards de pages web. Les spécialistes peuvent l’utiliser pour faire du web scraping gratuit à très grande échelle, permettant des analyses approfondies de l’ensemble du web, notamment dans le cadre de projets de recherche ou de veille à grande échelle.

N’hésitez pas à utiliser cette infographie sur votre site, à condition de mentionner la source et de créer un lien vers l’URL de notre blog à l’aide du code d’intégration ci-dessous :

En conclusion

Le web scraping est devenu un atout clé dans de nombreux secteurs, permettant d’automatiser la collecte de données à grande échelle. En 2025, choisir un bon outil scraping gratuit ou abordable est essentiel pour scraper un site efficacement.

Que ce soit avec des logiciels puissants comme Octoparse, des extensions de navigateur ou des solutions pour développeurs, la variété d’outils offre une grande flexibilité. La clé est de sélectionner celui qui correspond à votre besoin d’automatisation, à votre niveau technique et à votre volume de données.