Parfois, on voudrait extraire des données depuis les sites Web et puis les mettre dans Excel pour réaliser des analyses et des visualisations. Un des cas les plus fréquents, par exemple, c’est de récupérer les prix des produits depuis des sites d’e‑commerce comme les marketplaces ou les boutiques en ligne.

Le problème est là : Comment extraire données site web vers excel ?

Le copier-coller manuel ? Cela serait extrêmement fastidieux. Dans cet article, je vais vous introduire plusieurs façons pour extraire des données d’une page web vers excel. Pour éviter cette perte de temps, découvrons ensemble des méthodes efficaces.

Qu’est-ce que le web scraping Excel ?

Le web scraping Excel, c’est tout simplement le fait d’extraire automatiquement des données de sites web pour les organiser dans un tableau Excel prêt à être filtré, trié et analysé.

Si tu as déjà copié-collé un tableau depuis une page web vers Excel, tu as déjà fait du web scraping… mais à la main. La différence, c’est qu’ici tout est automatisé, même quand il y a des centaines ou des milliers de lignes.

Comment faire l’extraction de données vers excel?

En réalité, il existe plusieurs façons de récupérer des données depuis des sites web et de les envoyer vers un tableur comme Excel ou Google Sheets :

- Utiliser un outil de web scraping no‑code

- Exploiter les fonctionnalités intégrées d’Excel (ou les fonctions d’import de Google Sheets)

- Coder soi‑même l’extraction (par exemple avec VBA ou un script)

Dans la suite de l’article, on va commencer par la méthode la plus simple pour les non‑codeurs, à savoir l’outil de web scraping, puis on verra ce que permettent Excel et Google Sheets eux‑mêmes, ainsi que les options plus techniques.

Extraire des données d’une page web vers excel avec l’outil de scraping

Si vous cherchez un outil simple et facile à utiliser pour extraire des données de pages web vers Excel, et que vous ne souhaitez pas vous casser la tête à programmer, utiliser des outils de web scraping est une excellente idée.

Voici une petite sélection des meilleurs outils de scraping gratuits, qui sont parfaitement adaptés à des besoins réguliers et à grande échelle d’extraction de données, tout en garantissant leur stabilité.

🎯 Je vous recommande particulièrement Octoparse pour automatiser votre web scraping vers Excel. En quelques clics de souris et glisser-déposer, vous convertissez n’importe quel site web – tableaux inclus – en fichier Excel ou Google Sheets, sans aucune ligne de code, même pour des milliers de lignes.

Concrètement, vous collez l’URL de la page, l’outil auto-détecte les données (titres, prix, contacts, etc.) en 1 clic, puis vous exportez des millions de lignes directement en Excel pour analyse ou partage.

Transformer les sites web vers Excel, CSV, Google Sheets ou base de données.

Auto-détecter les sites Web et extraire les données sans aucun codage.

Scraper les sites populaires en quelques clics avec les modèles pré-construits.

Ne se trouver jamais bloqué grâce aux proxies IP et à l’API avancée.

Service Cloud pour programmer le scraping de données.

Web to Excel en seulement 3 clics

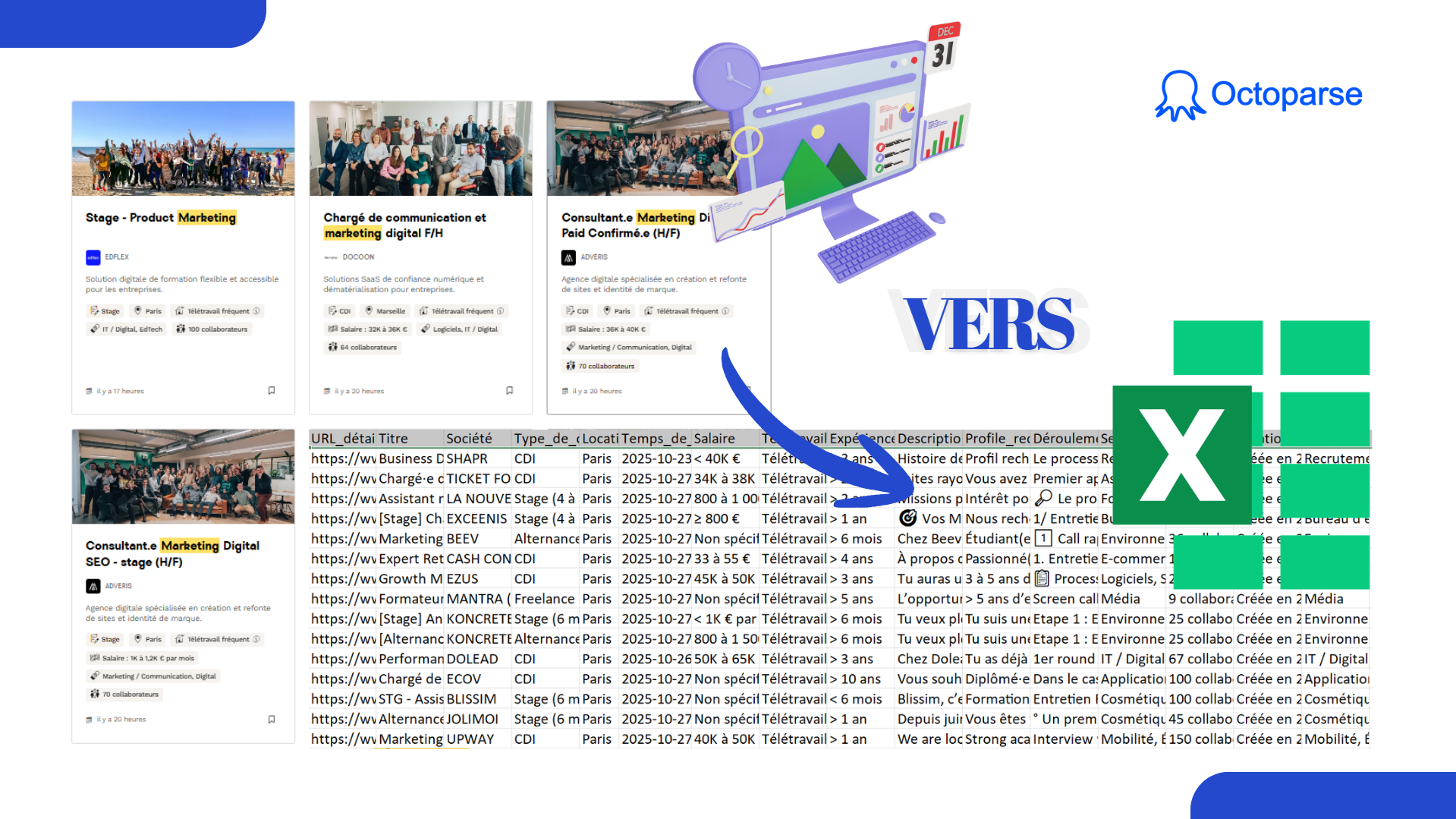

Imaginez que l’on souhaite extraire des données liées à la profession depuis des sites carrière. Je vais vous montrer comment je procède avec Octoparse pour récolter les offres d’emploi sur le site Welcome to the Jungle.

💰 Et le meilleur dans tout ça ? C’est totalement GRATUIT !

Étape 1 Cliquer sur “Démarrer”

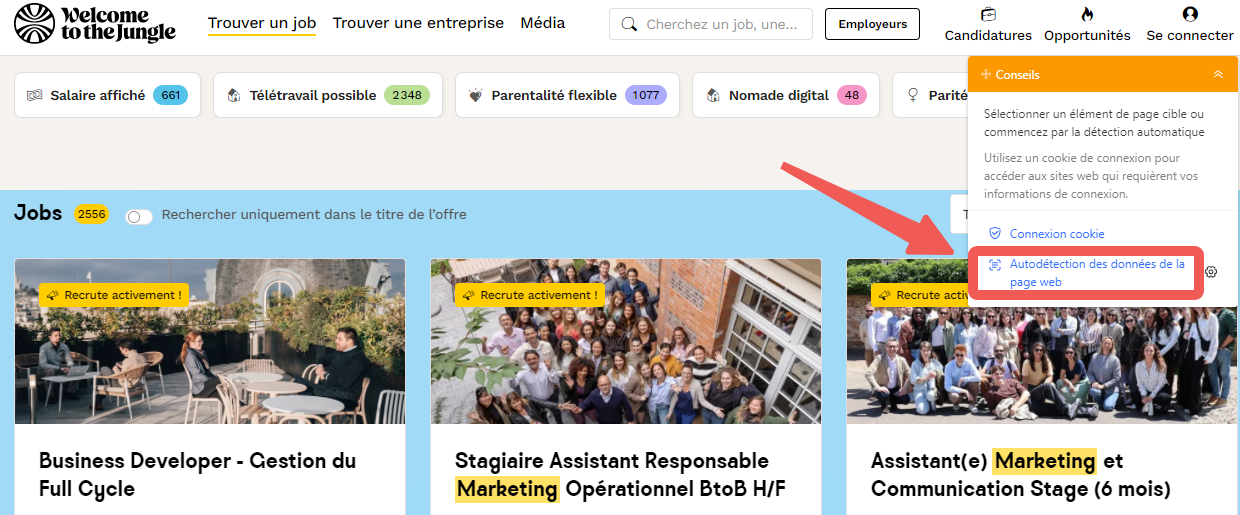

Après avoir entré mes critères de recherche sur le site Welcome to the Jungle (par exemple, postes de marketing à Paris en Île-de-France), je copie l’URL de la page et la colle dans Octoparse.

Ensuite, je clique sur le bouton “Démarrer” pour lancer la tâche de collecte. Ça y est, le processus démarre, et il ne me reste plus qu’à attendre que tout soit prêt.

Étape 2 Cliquer sur “Autodétection”

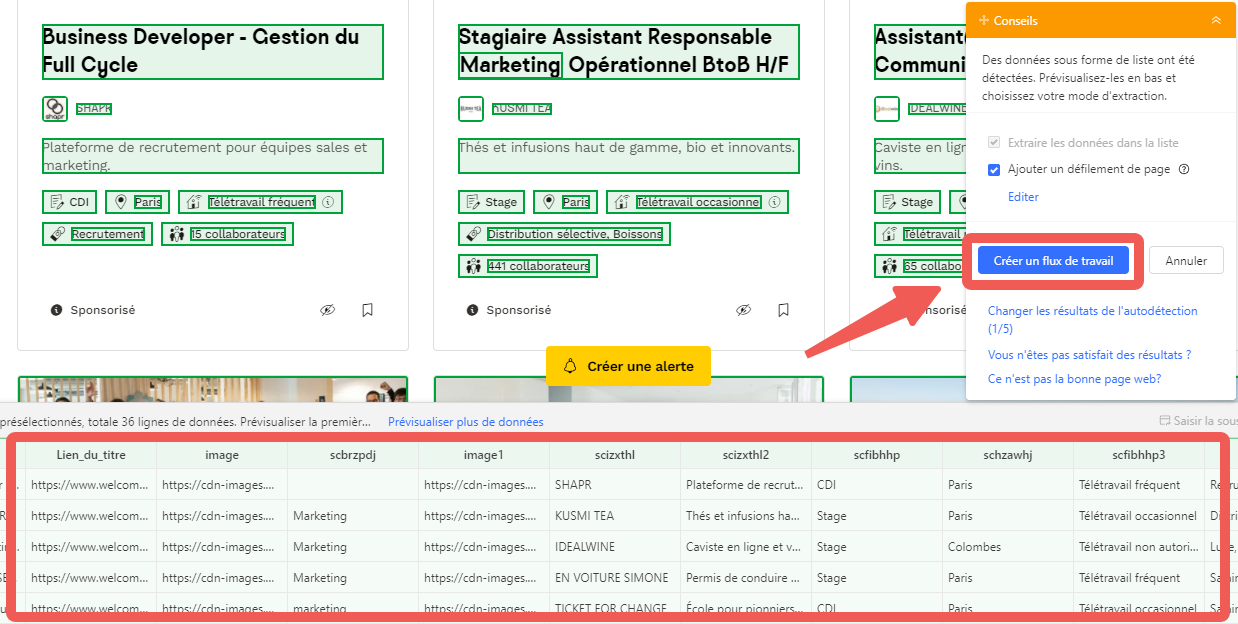

Une fois la tâche lancée, je clique sur “Autodétection des données de la page Web“. Octoparse se met alors à scanner la page web tout seul et à repérer automatiquement tous les éléments liés aux offres d’emploi : le titre, la localisation, l’entreprise, etc.

C’est vraiment pratique, car je n’ai pas besoin de sélectionner chaque élément manuellement, tout est fait en quelques secondes.

Étape 3 Cliquer sur “Exécuter”

Après l’autodétection, je sélectionne l’option “Créer un flux de travail“. À ce moment-là, je peux aussi supprimer ou affiner les données en temps réel.

Lorsque le flux de travail est prêt, je clique sur “Exécuter” pour lancer la collecte. La tâche tourne en arrière-plan, et en quelques instants, toutes les données sont extraites.

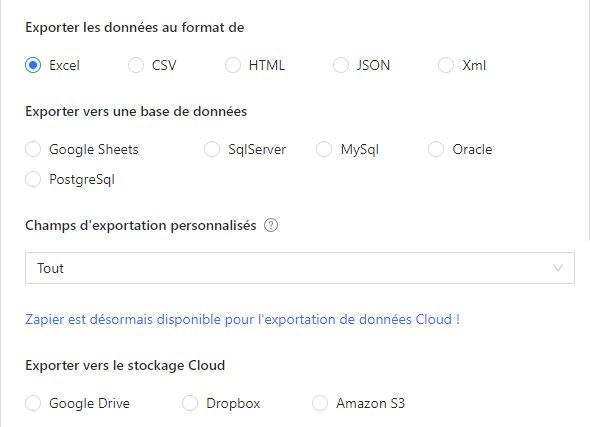

Et puis je peux facilement exporter ces informations dans un fichier Excel ou directement dans Google Sheets, pour analyser ou partager selon mes besoins.

Dans cette vidéo de démarrage rapide ci-dessous, vous découvrirez étape par étape comment lancer votre première extraction avec Octoparse. Du collage de l’URL à l’export Excel, tout est expliqué simplement avec l’interface réelle. Parfait pour visualiser le processus avant de vous lancer !

Modèles de scraping prêts à l’emploi

En plus de la collecte personnalisée, Octoparse offre aussi une grande bibliothèque de modèles prêts à l’emploi. Avec ces modèles, vous pouvez accéder à une large gamme de cas d’usage à travers le monde.

Que vous soyez dans le e-commerce, l’immobilier, la finance ou tout autre secteur, il y a forcément un modèle qui correspond à vos besoins. Cela vous permet de gagner énormément de temps tout en obtenant des résultats précis et efficaces.

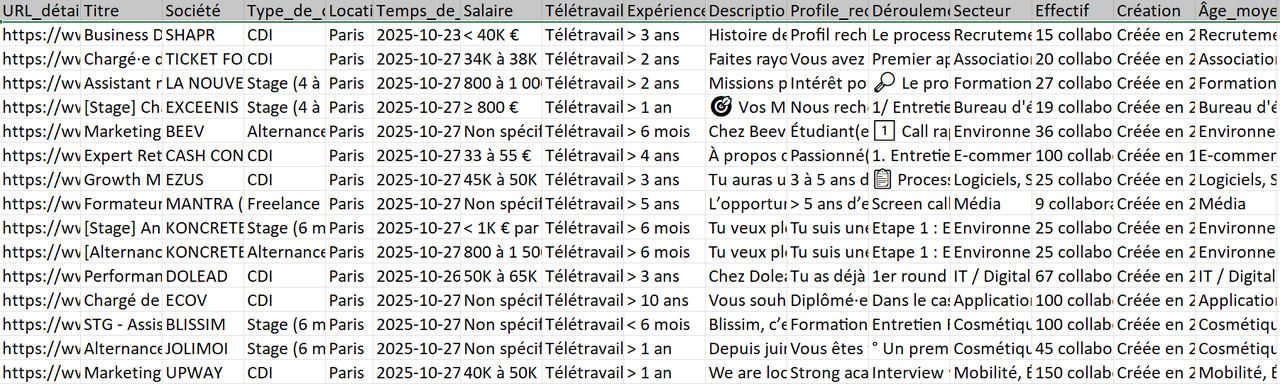

Voici les données que j’ai recueillies en utilisant le modèle Offres d’emploi Scraper de Welcome to the Jungle. Les champs sont complets et répondent à toutes sortes de besoins.

N’hésitez pas à cliquer ici pour faire un essai :

https://www.octoparse.fr/template/wttj-offres-scraper

🔥 Lancez votre aventure de web scraping en essayant d’autres modèles :

https://www.octoparse.fr/template/leboncoin-data-scraper

👉 En Savoir plus

Exporter les résultats de recherche de Google Maps vers Excel

💡 Astuces partagées pour booster votre scraping

Avec Octoparse, vous pouvez faire encore plus pour économiser du temps et obtenir des données nickel !

Voici 3 astuces qui vont vraiment changer votre façon de travailler :

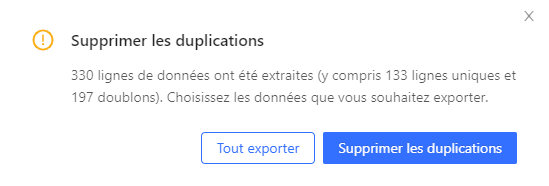

- Éliminez les doublons en 1 clic

Vous avez déjà passé des heures à nettoyer des listes Excel pleines de lignes répétées ? Octoparse propose une fonction de déduplication automatique intégrée. Vos données arrivent propres, sans doublons, directement prêtes pour l’analyse. Fini les filtres interminables dans Excel !

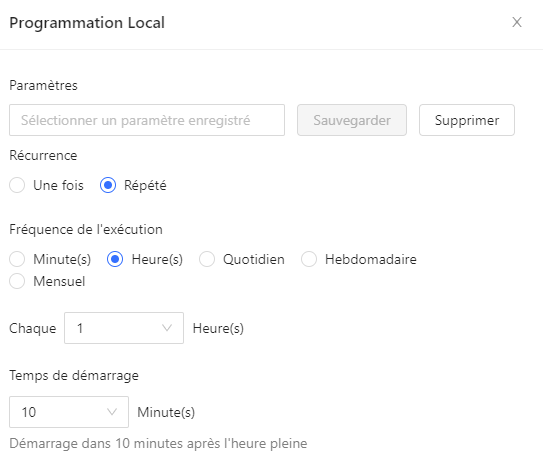

- Programmez vos extractions, dormez tranquille

Les prix évoluent ? Les offres d’emploi se renouvellent ? Configurez simplement une tâche planifiée (quotidienne, hebdomadaire, mensuelle), et Octoparse s’occupe de tout en arrière-plan.

Le matin, votre fichier Excel actualisé vous attend localement ou dans le Cloud, pendant que vous prenez votre café ☕.

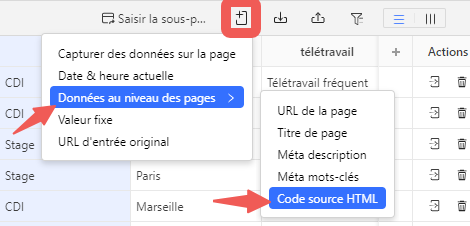

- Récupérez même le code source HTML si besoin

Pour les pros qui analysent le code source ou intègrent les données dans d’autres systèmes, Octoparse peut aussi extraire l’URL complète, les balises méta et le HTML brut de chaque page ou élément. Idéal pour les analyses techniques ou les intégrations automatisées.

Ces 3 fonctionnalités, c’est le combo parfait : moins de travail manuel, des données toujours fraîches, et une flexibilité totale. Votre web scraping passe de “possible” à “vraiment pratique au quotidien”.

Collecter des données d’un site web vers Excel via requêtes Web

Excel offre une fonctionnalité très pratique qui vous permet d’établir une connexion directe avec des pages web pour récupérer des données pertinentes pour votre travail.

Grâce à cette option alimentée par la puissance de Power Query(Requêtes Web Excel), vous pouvez importer facilement des informations telles que des tableaux, des prix, des avis ou d’autres données dynamiques, directement dans votre classeur.

Cela facilite grandement la gestion des données en ligne, et vous pouvez aussi actualiser ces données à tout moment pour obtenir les dernières mises à jour des sites que vous surveillez.

Le processus se résume à plusieurs étapes simples :

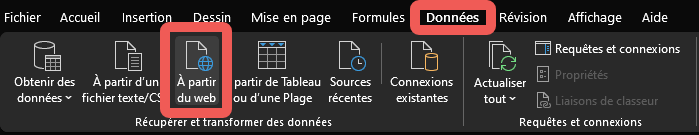

- Ouvrir Excel et accéder à la fonctionnalité d’importation

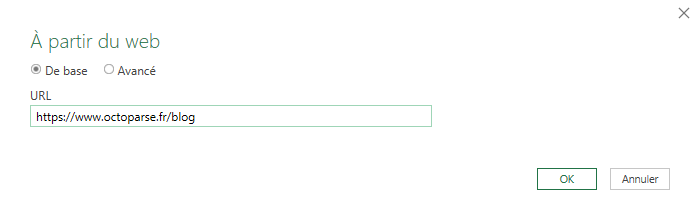

Lancez Excel, puis allez dans l’onglet Données. Cliquez sur À partir du web (ou Obtenir des données > À partir du web).

- Entrer l’URL de la page web

Dans la fenêtre qui s’ouvre, tapez l’adresse URL de la page web dont vous voulez extraire les données (par exemple, la page du Octoparse Blog sur le web scraping). Cliquez sur OK.

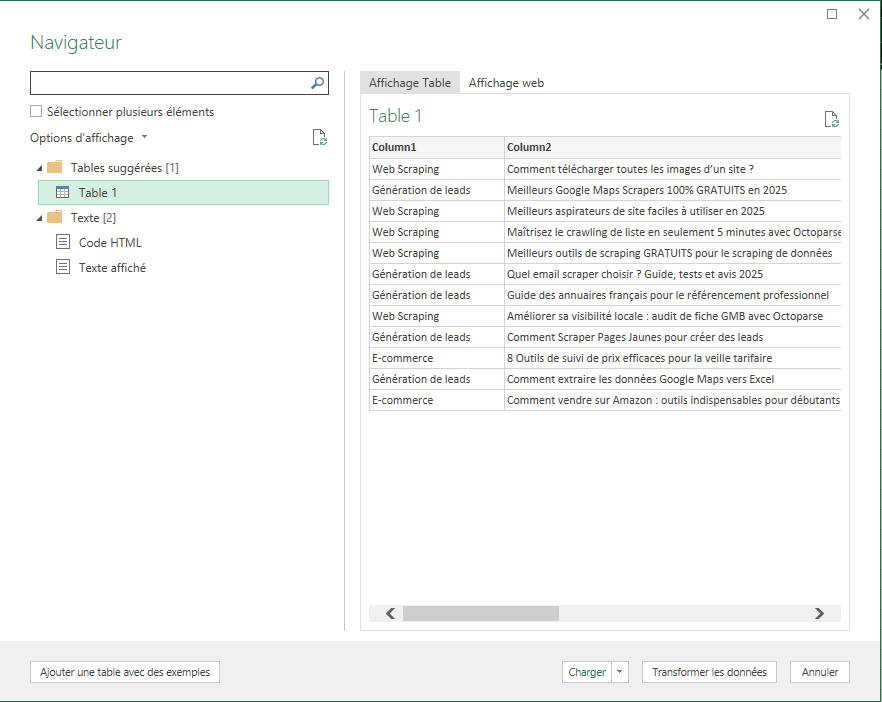

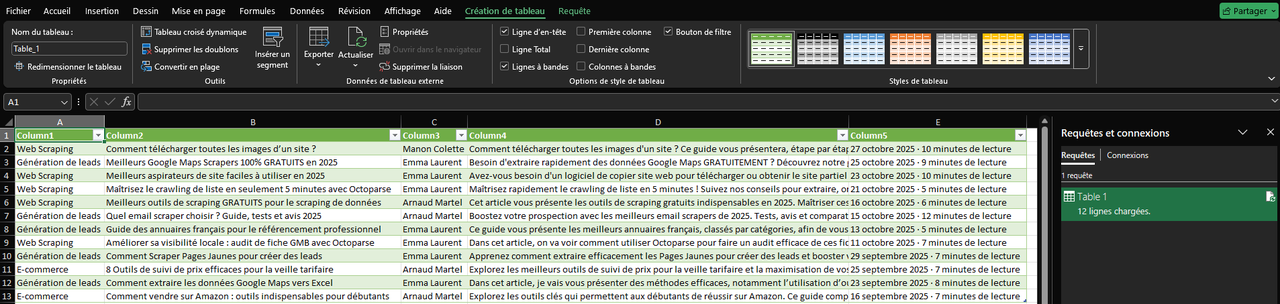

- Sélectionner les tables détectées

Excel affichera une liste de tables suggérées, qui sont des tableaux détectés automatiquement sur la page web. Choisissez la table qui vous intéresse, puis cliquez sur Charger ou Transformer.

- (Optionnel) Ajouter une table à l’aide d’exemples

Pour aller plus loin, vous pouvez utiliser la fonctionnalité “Ajouter une table à l’aide d’exemples“.

Il suffit d’indiquer quelques exemples de valeurs que vous souhaitez extraire (par exemple, le nom et le prix des jeux). Power Query utilisera des algorithmes intelligents pour reconnaître le modèle et extraire les données correspondantes.

- Finaliser l’importation

Une fois que les données extraites vous conviennent, cliquez sur OK pour charger la table dans Excel.

Vous pouvez ensuite utiliser l’Éditeur Power Query pour mettre en forme les données ou les charger directement dans la feuille.

💡 Astuces Excel : exploitez le web scraping au maximum

Une fois vos données dans Excel, voici les fonctions essentielles pour les transformer en insights concrets :

- VLOOKUP / RECHERCHEV (fusionner vos listes) Vous avez scrapé les prix sur un site + vos prix concurrents ? Utilisez

RECHERCHEVpour comparer automatiquement les prix et repérer les écarts. Exemple : matcher les noms de produits entre deux listes pour calculer vos marges. - SOMME.SI.ENS / SUMIFS (analyser par catégories) Vos données contiennent des catégories (ville, entreprise, type de produit…) ?

SOMME.SI.ENScalcule automatiquement les totaux par groupe. Exemple : total des salaires par ville pour vos offres d’emploi scrapées. - NB.SI / COUNTIF (repérer les tendances) Comptez rapidement combien d’offres correspondent à vos critères. Exemple : nombre d’offres “Marketing” à Paris vs Lyon en 1 formule.

- INDEX/EQUIV (alternative moderne à RECHERCHEV)

Plus flexible que VLOOKUP, parfait quand vos listes évoluent ou quand vous cherchez dans plusieurs colonnes.

Conseil pro : après chaque scraping, commencez toujours par TRI + SUPPRIMER DOUBLONS (onglet Données), puis enchaînez avec ces fonctions. Vos données brutes deviennent un tableau de bord en 5 minutes.

Ces formules transforment vos données scrapées de “liste brute” en rapport actionnable.

Obtenir des données Web à l’aide de VBA dans Excel

Le VBA (Visual Basic pour Applications) vous permet d’automatiser l’extraction de données web directement dans Excel grâce aux macros. Ces fichiers portent l’extension .xlsm et offrent une flexibilité intéressante pour les utilisateurs à l’aise avec un peu de programmation.

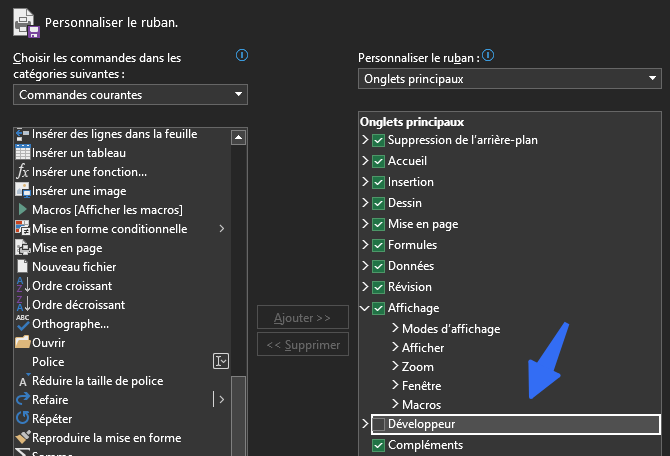

Préparation : activer l’onglet Développeur

Avant de commencer, activez l’onglet Développeur :

Fichier > Options > Personnaliser le ruban > cochez “Développeur” dans la colonne de droite, puis validez.

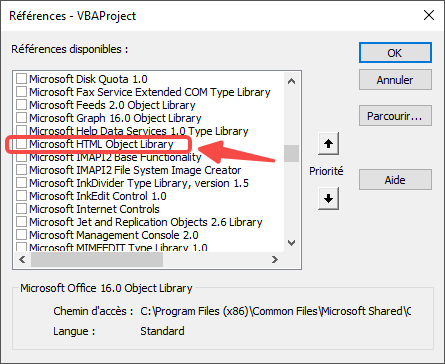

Étape 1 : Configurer les références VBA

- Cliquez sur Développeur > Visual Basic pour ouvrir l’éditeur

- Dans le menu, allez à Outils > Références

- Cochez ces deux options essentielles :

Microsoft Internet Controls

Microsoft HTML Object Library

- Cliquez sur OK

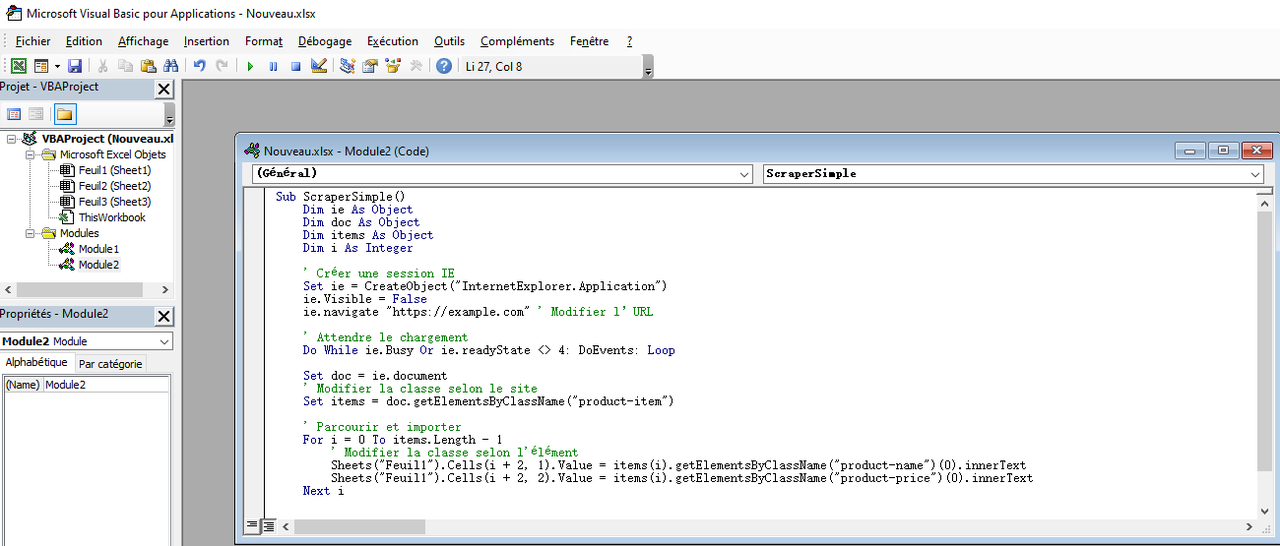

Étape 2 : Insérer le code VBA

- Dans l’éditeur VBA, cliquez sur Insertion > Module

- Copiez-collez ce script simple qui extrait des produits d’un site :

Étape 3 : Personnaliser et exécuter

- Adaptez le code :

Remplacez https://example.com par l’URL de votre site cible

Modifiez "product-item", "product-name", "product-price" selon les classes CSS du site (clic droit > Inspecter pour les voir)

- Exécutez : Appuyez sur F5 ou cliquez sur le bouton ▶️

Vos données apparaissent instantanément dans la Feuil1 !

💡 Astuces visualisation : transformez vos données en graphiques

Une fois vos données extraites avec VBA, voici comment les rendre visuellement impactantes en 3 étapes :

- Graphique en colonnes dynamiques (pour comparer)

Sélectionnez vos données —— Insertion > Graphique en colonnes.

Cas concret : comparez les prix scrapés par concurrent ou les salaires par entreprise. Ajoutez filtres de segmentation pour trier par date/catégorie d’un clic.

- Tableaux croisés dynamiques (pour analyser rapidement)

Insertion > Tableau croisé dynamique. Glissez “Ville” en lignes, “Salaire” en valeurs —— Excel calcule automatiquement moyennes, totaux, tendances.

Exemple : nombre d’offres par secteur ET par localisation en 1 tableau.

- Mise en forme conditionnelle (pour repérer les opportunités)

Accueil > Mise en forme conditionnelle > Barres de données. Les valeurs les plus hautes (salaires élevés, prix bas) se colorent automatiquement.

Pro tip : utilisez Nuances de couleur pour marquer les “outliers” (offres > 50k€, par exemple).

⚡ Astuce ninja : Ctrl+T pour transformer instantanément vos données en Tableau structuré —— vos graphiques se mettent à jour automatiquement à chaque nouveau scraping VBA.

Externaliser votre projet du web scraping Excel

Pour gagner du temps et vous concentrer pleinement sur votre activité principale, faire appel à une équipe spécialisée pour la collecte de données est la solution la plus efficace.

Octoparse, que nous venons de mentionner, propose également des services de données visant à vous aider à obtenir des données de sites Web de manière adaptée à vos besoins, et à vous fournir des données structurées au format Excel ou dans tout autre format souhaité.

Pour toute demande ou pour en savoir plus, n’hésitez pas à nous contacter à support@octoparse.com.

En conclusion

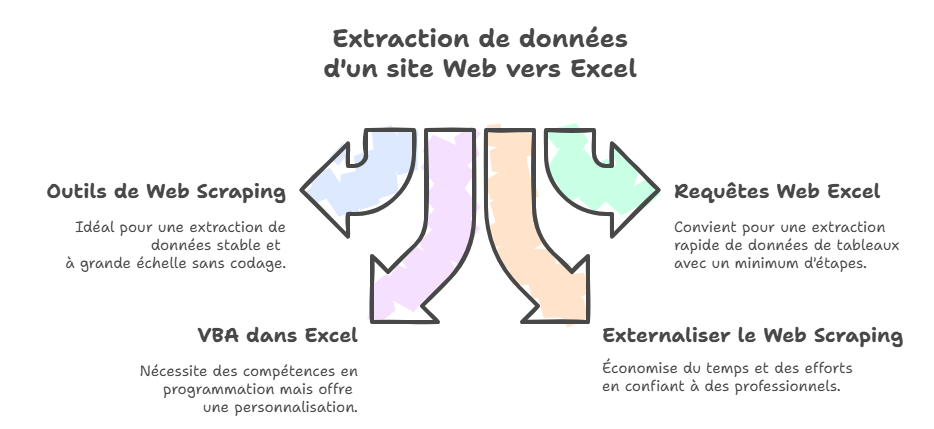

N’hésitez pas à utiliser cette infographie sur votre site, en mentionnant la source, et à insérer un lien vers notre blog à l’aide du code d’intégration ci-dessous :

Nous avons présenté quatre méthodes pour extraire des données de sites Web vers Excel. Alors que ces deux méthodes, réalisées à l’intérieur d’Excel, semblent plus pratiques, elles présentent des limites en termes de volume et de diversité des données extraites.

L’utilisation d’un outil de web scraping nocode est une excellente solution pour les non-informaticiens. De plus, vous pouvez externaliser la collecte de données si vous préférez concentrer vos efforts sur vos activités principales.

Pour obtenir un guide étape par étape sur la façon d’extraire des données d’un site vers Excel, vous pouvez consulter d’autres articles de blog d’Octoparse.

FAQ

- Comment extraire des données vers Excel ?

Plusieurs méthodes : Power Query (onglet Données > À partir du web) pour les tableaux simples, outils no-code comme Octoparse pour les sites complexes, ou VBA pour l’automatisation avancée. Octoparse transforme n’importe quel site en Excel en quelques clics, sans programmation.

- Puis-je utiliser directement Excel pour extraire des données d’un site Web ?

Oui, Excel propose la fonction “Obtenir des données” (Power Query), permettant d’importer rapidement des tableaux statiques. Cependant, cette méthode a ses limites pour le contenu dynamique ou paginé.

- Si le contenu du site Web est complexe ou si je souhaite automatiser le processus, quelle méthode est la plus adaptée ?

Dans ce cas, des outils professionnels de web scraping comme Octoparse sont recommandés, car ils supportent le chargement dynamique, la pagination et nécessitent peu ou pas de codage.

- La programmation VBA permet-elle d’automatiser l’extraction de données Web ?

Oui, mais cela nécessite des compétences en programmation. En rédigeant des scripts VBA, vous pouvez automatiser la récupération, mais cela demande aussi une maintenance régulière.

- Peut-on actualiser automatiquement les données extraites dans Excel ?

Oui, avec Power Query ou certains outils de web scraping, il est possible de programmer des rafraîchissements réguliers, sous réserve que la structure du site reste stable.

- Comment convertir le HTML d’une page web en fichier Excel ?

Octoparse permet d’extraire directement le code HTML brut (ou les éléments structurés) de n’importe quelle page web et de l’exporter en colonnes Excel bien organisées. L’outil récupère l’URL complète, les balises méta, le HTML des éléments spécifiques, puis les structure automatiquement en tableau (titres, prix, descriptions, etc.) prêt pour l’analyse ou l’intégration dans d’autres systèmes.