Aujourd’hui, accéder aux données précises et à jour des entreprises locales sur Google Maps est devenu essentiel pour de nombreux professionnels, qu’il s’agisse de marketeurs, de commerciaux ou d’entrepreneurs.

Le Google Maps scraper est l’outil idéal pour extraire facilement ces informations, sans effort ni compétence technique particulière. Cet article vous présente les meilleurs Google Maps scrapers 100% GRATUITS en 2025, qui vous permettront de collecter rapidement des données fiables pour booster votre activité.

Pourquoi extraire des données de Google Maps ?

L’extraction de données depuis Google Maps permet d’accéder à une grande variété d’informations particulièrement précieuses pour les entreprises : noms des établissements, catégories d’activités, adresses complètes, coordonnées téléphoniques, sites web officiels, adresses e-mail, avis clients et notes, photos, horaires d’ouverture, et bien plus encore.

Ces données offrent une vision complète du paysage commercial local et facilitent la prospection, l’analyse concurrentielle ou la découverte de nouveaux marchés. C’est cette richesse et cette diversité de données qui font du scraping Google Maps un outil essentiel pour maîtriser son environnement commercial.

Comment scraper Google Maps GRATUITEMENT ?

La méthode la plus accessible consiste à extraire manuellement les informations depuis les résultats de recherche de Google Maps – une solution simple mais limitée lorsqu’il s’agit de gros volumes.

Pour aller plus loin sans rien payer, on peut recourir à des outils de scraping NOCODE comme Octoparse qui automatisent la collecte via des modèles préconfigurés et ne demandent aucune compétence en programmation.

Les profils plus techniques privilégient souvent l’écriture de scripts Python ou l’utilisation d’API open source, deux options également gratuites mais nécessitant un certain savoir‑faire.

Meilleurs outils de scraping pour Google Maps sans frais

👉 Pour vous aider à optimiser facilement cette tâche, nous passerons en revue divers outils gratuits, adaptés à tous les niveaux, que vous soyez débutant ou plus expérimenté :

Octoparse – Solution idéale pour le scraping sur Google Maps

Octoparse est un outil de web scraping simple et intuitif, conçu pour être accessible à tous – même à ceux qui n’ont jamais touché une ligne de code.

En bénéficiant d’un tutoriel riche et l’interface en glisser‑déposer, chacun peut créer ses propres web crawlers en quelques minutes seulement. Vous pouvez ainsi collecter des données à n’importe quel site souhaité, sans connaître le Python, le JavaScript ou le JSON. Quelques clics sont suffisants pour que vous soyez en mesure de transformer les sites Web en données structurées précieuses.

Il y a généralement trois options pour le scraping de Google Maps avec Octoparse : créer un crawler personnalisé à partir de zéro, combiner l’auto-détection (qui facilite la création du crawler) ou utiliser des modèles de web scraping pour des scénarios dans le monde entier.

💡 Voici comment créer votre propre web scraper pour collecter des informations sur Google Maps, en toute simplicité :

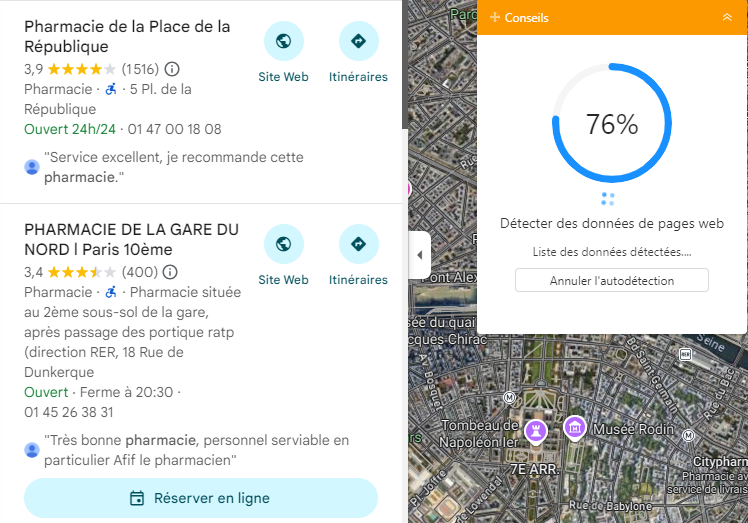

Tout d’abord, j’ouvre Octoparse et crée une nouvelle tâche. Dans le champ d’URL, je colle le lien de Google Maps avec les résultats de recherche que je veux extraire – par exemple, “Pharmacies à Paris”.

Ensuite, je laisse Octoparse détecter automatiquement les éléments pour créer un flux de travail: il reconnaît tout de suite les noms d’entreprises, adresses, numéros de téléphone et notes. Je valide les champs que je veux garder, et le tour est joué.

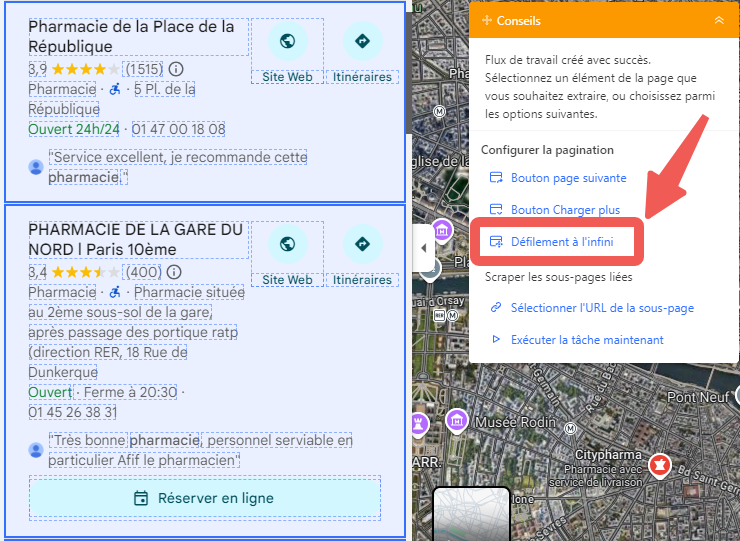

Puis, je configure la pagination automatique pour que Octoparse passe tout seul d’une page de résultats à la suivante. En quelques clics, j’ai accès à des centaines d’établissements sans avoir besoin d’intervenir.

Enfin, je lance l’extraction. Pendant que Octoparse fait le travail en arrière-plan, je peux tranquillement faire autre chose. Quand c’est terminé, j’exporte mes données vers Excel ou Google Sheets et je retrouve une liste propre et bien organisée de tous les lieux que j’ai collectés.

🔥 Essai gratuit de 14 jours avec 20 000+ données

Avec la méthode ci-dessus, vous pouvez choisir de créer votre propre scraper sur n’importe quelle page web, y compris Google Maps. Bien sûr, vous pouvez également utiliser les modèles dédié à Google Maps proposé par Octoparse pour extraire des données cartographiques.

Transformer les sites web vers Excel, CSV, Google Sheets ou base de données.

Auto-détecter les sites Web et extraire les données sans aucun codage.

Scraper les sites populaires en quelques clics avec les modèles pré-construits.

Ne se trouver jamais bloqué grâce aux proxies IP et à l’API avancée.

Service Cloud pour programmer le scraping de données.

Il suffit d’entrer vos paramètres et de cliquer dans le client d’Octoparse pour extraire toutes les données dont vous avez besoin.

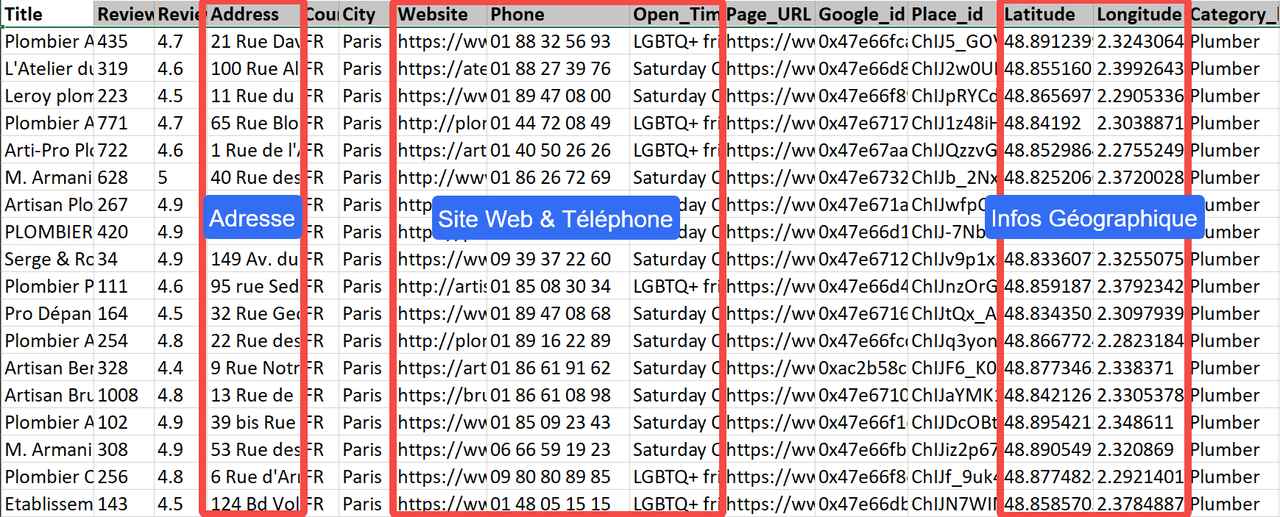

Par exemple, si je souhaite collecter des plombiers à Paris sur Google Maps, voici les données que j’ai obtenues en utilisant Google Maps Leads Scraper (via mots-clés) :

https://www.octoparse.fr/template/google-maps-scraper-store-details-by-keyword

Il suffit d’entrer les paramètres “Plombier, Paris“, puis de définir le nombre de pages à parcourir. En quelques minutes, vous pouvez obtenir un jeu de données complet (y compris les coordonnées GPS) comme celui-ci :

💰 Profitez d’un essai GRATUIT de 14 jours pour récupérer au moins 20 000 données, sans aucune programmation.

Pour en savoir plus sur l’API d’Octoparse ou pour commencer à l’utiliser, n’hésitez pas à nous contacter par le mail : support@octoparse.com. On est là pour vous aider à booster votre prospection !

Souhaitez-vous également collecter des adresses email ?

Vous pouvez aussi coller directement les liens URL collectés dans le modèle Contact Details Scraper. Octoparse propose plusieurs solutions pour votre génération de leads :

https://www.octoparse.fr/template/contact-details-scraper

ParseHub – Solution multiplateforme simple

ParseHub est un outil de scraping qui se distingue par sa facilité d’utilisation, son interface graphique conviviale permet de définir facilement des règles de collecte sur des pages web dynamiques et de gérer des projets comportant plusieurs pages.

Pour Google Maps, ParseHub offre la possibilité de naviguer entre les résultats, d’extraire des champs clés comme le nom de l’établissement, l’adresse, les numéros de téléphone, puis d’exporter facilement les données en CSV ou Excel.

Le plan gratuit est idéal pour de petits projets et fournit suffisamment de quotas pour tester l’outil et obtenir rapidement des lots de données structurées. Toutefois, pour des volumes importants, il peut être nécessaire de passer à une formule payante ou d’envisager d’autres alternatives.

Diffbot – Outil d’extraction de données structurées

Diffbot automatise la collecte d’informations à partir de sources web variées, y compris des pages cartographiques, dès lors que ces données sont accessibles sous une forme lisible.

En pratique, Diffbot propose des API qui renvoient des données bien structurées, faciles à intégrer dans vos flux analytiques. Son principal avantage réside dans la qualité de la structuration, ce qui réduit considérablement le besoin de scripts personnalisés.

Cependant, l’offre gratuite est limitée, mais elle peut tout de même être utile pour des projets pilotes ou pour tester rapidement la pertinence des données avant d’investir dans une formule payante.

Pour une utilisation régulière et à grande échelle, notamment sur Google Maps, il faudra prévoir un budget et respecter les conditions d’accès.

Webscraper – Extension légère pour un scraping rapide

WebScraper est un autre outil de web scraping capable de répondre à vos besoins pour scraper Google Maps.

Par rapport à Octoparse, son avantage est qu’il s’agit d’une extension de navigateur : il suffit d’installer l’extension WebScraper dans Chrome pour commencer à l’utiliser.

Comme Octoparse, c’est aussi un outil pointeur-cliquer, donc les utilisateurs n’ont pas besoin d’écrire de code pour récupérer des données.

Cependant, l’extension ne possède pas autant de puissance et est moins flexible lorsqu’il s’agit de gérer des structures de pages Web complexes ou de traiter de gros volumes de données.

Framework Python ou Bibliothèque

Vous pouvez utiliser de puissantes bibliothèques Python comme Scrapy et Beautiful Soup pour personnaliser votre crawler et extraire précisément ce que vous souhaitez.

Plus concrètement, Scrapy est un framework qui permet de télécharger, nettoyer et stocker des données provenant de pages web, avec beaucoup de fonctionnalités intégrées pour vous faire gagner du temps. Beautiful Soup est une bibliothèque qui aide les programmeurs à extraire rapidement les informations des pages web. Avec ces outils, il est nécessaire d’écrire soi-même du code pour construire un robot capable de tout gérer.

Le seul inconvénient, c’est que ce type de web scraping est réservé aux programmeurs ou aux freelancers techniques. Bien qu’il soit accessible, ce n’est pas à la portée de tout le monde.

Projets Open Source sur GitHub

On peut également trouver de bons projets open source sur GitHub, créés par d’autres pour explorer Google Maps, comme ce projet par exemple.

Même si ces projets permettent de ne pas écrire tout le code soi-même, il est quand même utile de connaître les bases du codage et d’avoir quelques notions pour faire fonctionner le script. Cela peut être difficile pour ceux qui connaissent peu la programmation.

De plus, la qualité et la quantité des données dépendent fortement du projet open source que vous utilisez, qui peut manquer de maintenance ou d’actualisation. En outre, la sortie se limite souvent à un fichier .txt, ce qui n’est pas idéal si vous souhaitez collecter de très grandes quantités de données.

Google API – Option gratuite limitée

Oui, la plateforme Google Maps propose l’API Places, qui est l’un des meilleurs moyens pour collecter des données directement depuis Google Maps.

Les développeurs peuvent obtenir des informations à jour sur des millions de lieux en envoyant des requêtes HTTP. Avant de pouvoir utiliser l’API Places, vous devrez créer un compte et générer votre propre clé API.

Cependant, les champs de données fournis via l’API sont limités, et il se peut que vous n’obteniez pas toutes les informations dont vous avez besoin.

L’API Places n’est pas gratuite. Voici un aperçu rapide des coûts :

- Les données relevant de la catégorie « Basic » comme l’adresse, l’état du commerce, l’icône, le nom, si c’est temporairement fermé, l’URL, les photos, le type, etc., sont gratuites.

- Pour les données de contact telles que les heures d’ouverture, le numéro de téléphone ou le site web, le coût est de 0,003 USD par requête pour moins de 10 000 requêtes, puis 0,0024 USD pour plus de 10 000 et moins de 50 000 requêtes. Au-delà de 50 000 requêtes, il faut contacter le service commercial.

- En ce qui concerne les données liées à l’atmosphère, telles que le niveau de prix, l’évaluation ou les avis clients, la tarification se présente comme suit :

Ce dernier aperçu est une synthèse rapide. Si vous souhaitez connaître les prix pour d’autres types de requêtes ou le tarif complet, cliquez sur le lien dédié aux tarifs de l’API Google Maps.

En conclusion

Les bons outils font les bons ouvriers. Le scraping de données n’est pas une tâche simple, sauf si l’on trouve la bonne méthode.

Je vous ai présenté ici des meilleurs outils pour extraire des données de Google Maps, à vous de choisir celui qui correspond le mieux à vos besoins, votre budget et votre niveau en programmation.

Bon scraping !

FAQs

- Comment extraire les données Google Maps vers Excel

Vous pouvez utiliser des outils comme Octoparse ou ParseHub pour le scraping de données, puis exporter l’information directement en format CSV ou Excel pour une analyse facile.

- Puis-je extraire les emails depuis Google Maps ?

Google Maps ne fournit pas directement les emails des entreprises, mais vous pouvez parfois les trouver sur leurs sites web officiels ou via des Email scrapers d’Octoparse avec les données extraites.

- Quels sont les meilleur Google Maps scrapers gratuits ?

Parmi les outils gratuits populaires en 2025, Octoparse, ParseHub, Diffbot, et WebScraper sont très recommandés pour leur efficacité et leur convivialité, même pour les débutants.