Le web scraping devient un méthode populaire et presque inévitable pour récupérer des données depuis de sites Web. Quand le besoin de données mises à jours en temps réel devient plus critique, des fournisseurs de service de web scraping se précipitent de déployer l’exportation planifiée ou API pour faciliter l’exportation de données en temps réel.

Dans cet article, on verra comment utiliser API pour obtenir en temps réel les données nettoyées et structurées qu’on extrait depuis des sites Web avec un logiciel de web scraping.

Données en temps réel sont recherchées par tous les secteurs

Personne ne doute de l’importance des données en temps réel. Il est généralement le cas que plus vous disposez d’informations à jour, plus vous avez de choix.

Le scraping de sites Web en temps réel peut nous aider à prendre des décisions rapidement. Par exemple, si une entreprise vend des vêtements en ligne, c’est nécessaire pour son site Web et son centre de service à la clientèle de saisir les données les plus récentes d’inventaire pour éviter que les articles en rupture de stock soient commendés. Si un article n’a que 5 en stock et que le client essaie d’en acheter 6, ou si une commande du client est annulée à cause de l’indiponibilité du style / couleur / taille de l’article voulé, le client peut être informé et sélectionner à nouveau un autre produit similaire, l’entreprise arrive ainsi à découvrir les meilleures ventes en ligne.

De même, le département financier peut avoir besoin de données en temps réel pour analyser les indicateurs économiques ou pour faire une comparaison entre le budget et la réalité.

Un autre exemple à noter est le scraping de données boursières en temps réel à partir de sites d’informations financières tels que Google Finance, Yahoo Finance, etc. Pour faciliter l’investissement, vous êtes obligé d’obtenir des cotations boursières en temps réel, y compris le cours actuel, les bénéfices et les estimations, ou encore d’autres données d’investissement affichées sur de nombreux fournisseurs d’informations en ligne. Pour obtenir les dernières données boursières et évaluer les actions d’une entreprise, vous devez rester attaché à ces sites Web, garder un œil sur ces informations boursières et prendre des mesures immédiates face aux changements soudains des données boursières, afin de vous assurer que votre investissement répond à vos attentes.

API pour exporter en temps réel les données récupérées

Une fois que vous avez collecté les données depuis des sites Web, vous aurez envie de connecter tout de suite les données récupérées à votre machine. L’API (interface de programme d’application) est un moyen d’y parvenir, car elle permet à une application d’interagir avec un autre système, bibliothèque, logiciel, etc. L’API vous permet de contrôler et de gérer les données récupérées – vous pouvez faire une demande pour les données scrapées et les intégrer à vos machines.

Imaginez que vous commandez deux salades à emporter (données) chez McDonald (API), vous les obtiendrez à la sortie une fois la commande faite. Il y a un panneau électronique sur lequel les conducteurs peuvent choisir les nourritures qu’ils veulent commander et voir le billet après avoir terminé la commande. De même, n’importe quand vous voulez demander des données via une API basée sur le cloud, vous effectuez simplement des appels d’API et obtiendrez immédiatement les données stockées dans le cloud.

Comment automatiser ce processus de scraper les contenus du site Web en temps réel et obtenir les informations comme vous le souhaitez ?

Octoparse et sa web scraping API seraient votre meilleur choix.

Octoparse pour scraper des données et les exporter avec API

Octoparse est un logiciel de web scraping gratuit, qui est choisi par de nombreuses entreprises pour collecter des données depuis des sites Web. C’est un outil facile à utiliser mais très puissant dans le scraping de données.

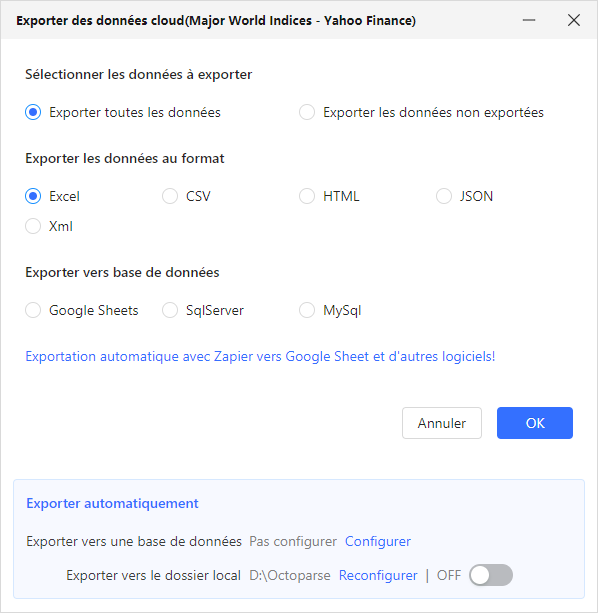

S’agissant de l’exportation de données déjà scrapées, Octoparse supporte pour l’instant l’exportation planifiée, l’exporation automatique vers un dossier local, l’exportation automatique vers Goolge Sheet, MySql, SqlServer.

OpenAPI est également disponible pour l’exportation de données. Vous pouvez consulter le dossier OpenAPI pour continuer votre configuration.

En conclusion

Il n’est plus à se douter sur l’importance des données mises à jour en temps réel. Octoparse travaille en donnant une solution complète pour tout automatiser : de l’extraction de données, au nettoyage de données, en passant par l’exportation de données. Il offre le plus de choix aux utilisateurs pour facilter l’application de données, parmi lesquels, OpenAPI permettant de connecter ces données avec votre système.