Avez-vous besoin d’analyser les tendances sociales, de surveiller la réputation d’une marque ou d’un individu, et d’alimenter diverses recherches académiques ou professionnelles ? Sans doute, le scraping des tweets sur Twitter est le choix essentiel pour vous. Il est crucial de pouvoir extraire rapidement et efficacement les informations pour rester compétitif avec la quantité exponentielle de données générées chaque jour sur la plateforme sociale.

On vous propose ce guide simple pour vous comprendre à scraper des tweets sans la requise de compétences en programmation : vous pourrez automatiser le web scraping sur Twitter en quelques clics seulement avec Octoparse.

Twitter scraping : méthode étape par étape

Utiliser les modèles préconçus pour scraper des tweets

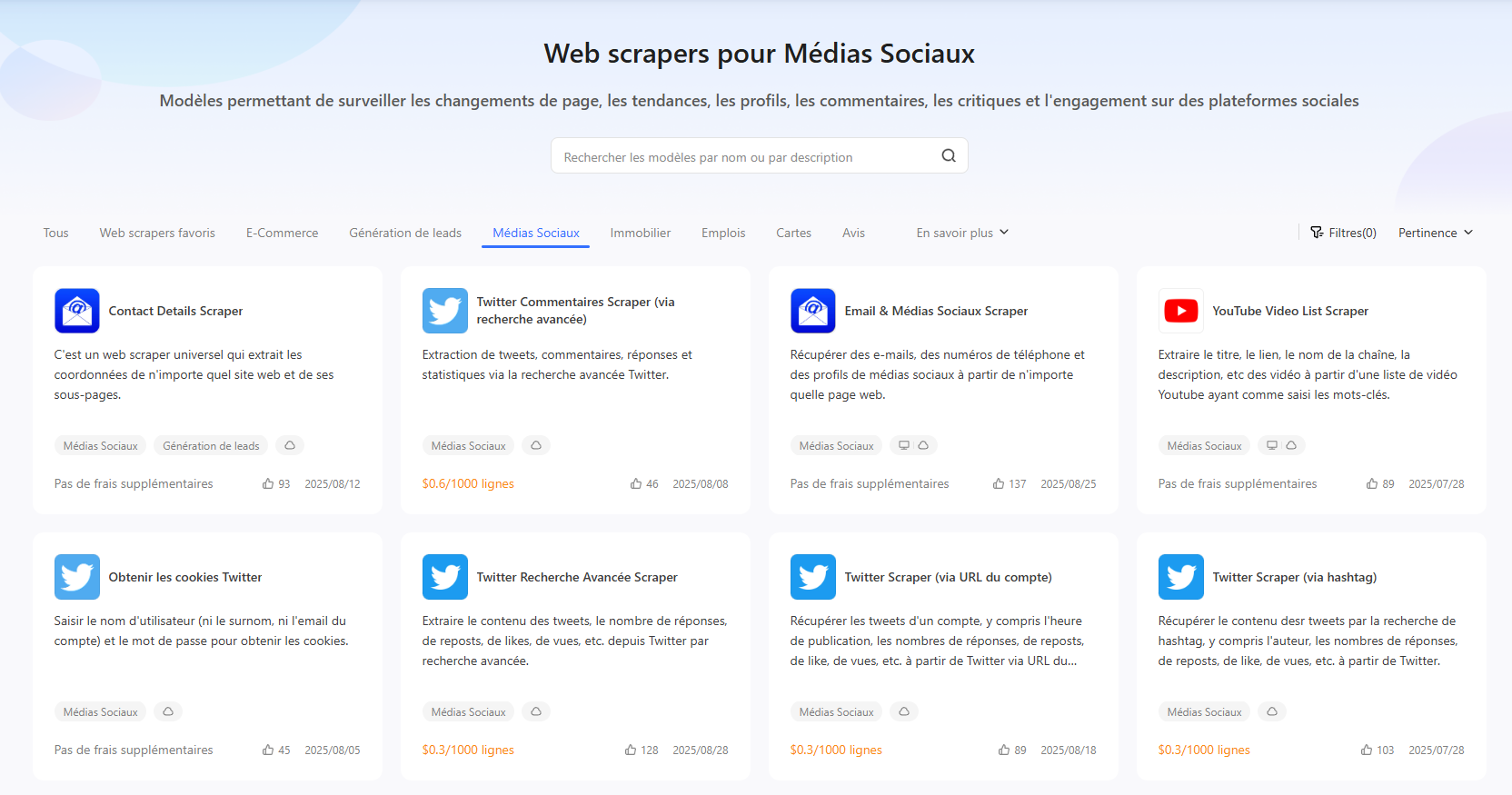

Les modèles prédéfinis d’extraction de tweets sont la meilleure solution pour commencer facilement à scraper. Par exemple, si vous voulez récupérer tous les tweets parlant d’un événement ou d’un sujet précis, il suffit d’entrer le hashtag ou le mot-clé lié à ce sujet dans le modèle, selon les processus. En quelques secondes, tout sera prêt : le modèle va automatiquement recueillir tous les tweets qui correspondent.

Avec Octoparse, on vous présente plus de 500 modèles du monde entier. Ce processus est simple, rapide et très pratique si vous cherchez à faire de l’extraction automatique de tweets sans coder. Utiliser ces modèles préconfigurés est souvent la solution la plus efficace et la plus simple, non seulement pour les collections des réseaux sociaux.

Octoparse a servi des millions d’utilisateurs par ses avantages :

- Facile à utiliser grâce à son UI intuitive

- Détection automatique de la structure des pages Web

- Cloud service accessible

- Aucune limite dans le nombre de données extraites

- Programmation de scraping

- Exportation automatique de données

- Essai gratuit de 14 jours des plans premium

- Version gratuite accessible

Transformer les sites web vers Excel, CSV, Google Sheets ou base de données.

Auto-détecter les sites Web et extraire les données sans aucun codage.

Scraper les sites populaires en quelques clics avec les modèles pré-construits.

Ne se trouver jamais bloqué grâce aux proxies IP et à l’API avancée.

Service Cloud pour programmer le scraping de données.

Utiliser Twitter Scraper prêts à l’emploi

Pour le scraping de Twitter, Octoparse propose plusieurs scrapers dont les saisies se diffèrent : via hashtags, via mot-clé ou via URL de résultat de recherche. Il vous faut démêcher votre projet de données d’abord et puis aller trouver le modèle qui correpond le mieux à votre besoin.

Par ici, on va voir comment récupérer les tweets avec le modèle intitulé Tweets & Commentaires Scraper (via URL et les mots-clés de recherche)

https://www.octoparse.fr/template/Twitter-scraper-by-keywords

https://www.octoparse.fr/template/Twitter-scraper-by-account-url

Étape 1 – Trouver le tweet scraper ciblé

L’ensemble des modèles accessibles peuvent être explorés dans l’application ou sur notre site web. Vous pouvez rechercher par catégories ou par mots-clés.

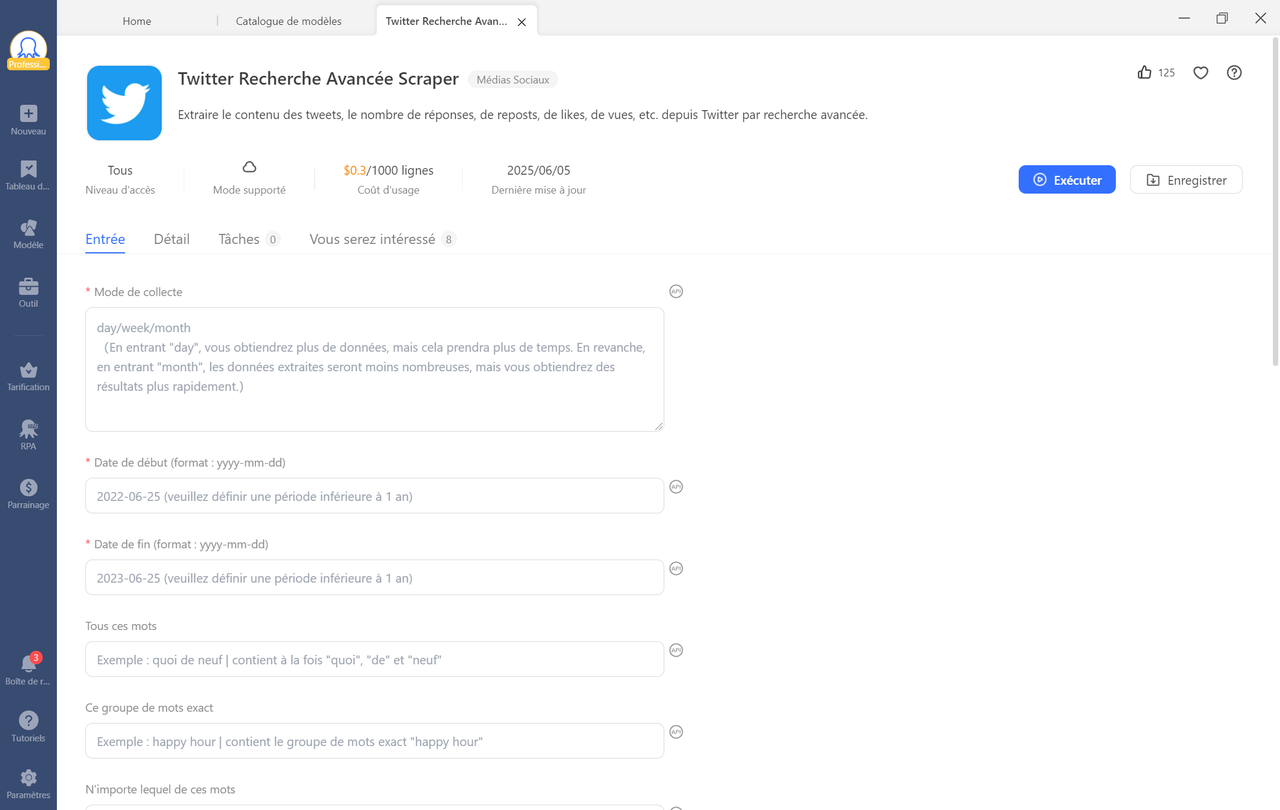

Étape 2 – Lire l’introduction et saisir les paramètres

Le modèle cible trouvé, il est temps à lire en détail l’introduction pour comprendre comment l’utiliser, savoir l’aperçu de données et les paramètres à saisir. S’il correspond justement à votre besoin, vous pouvez saisir les paramètres selon les instructions et puis exécuter la tâche.

Étape 3 – Exécuter la tâche et exporter les données

Vous pouvez choisir d’exécuter la tâche sur Cloud ou localement sur votre appareil.

Une fois l’extraction terminée, vous pouvez exporter les données dans des feuilles Excel, CSV, HTML, SQL, ou les diffuser dans votre base de données en temps réel via les API d’Octoparse.

Créer un tweet scraper personnalisé

Parfois, les modèles prêts à l’emploi ne suffisent pas pour récupérer précisément toutes les données dont vous avez besoin. Dans ce cas, vous pouvez créer un scraper personnalisé avec le meilleur outil pour scraper Twitter avec Octoparse.

Comment faire ?

Étape 1 : Saisir l’URL cible dans la barre de recherche

Par exemple, si je voudrais extraire tous les posts de OctoparseFr

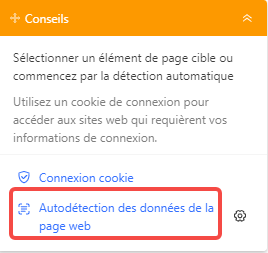

Étape 2 : Créer le flux de travail à l’aide de la détection automatique

Quand la page web est pleinement chargée, vous pouvez cliquer sur le bouton pour lancer la détection automatique des données de la page Web. Le robot va créer automatiquement un flux de travail de scraping pour vous.

Étape 3 : Exécuter la tâche et exporter les données

Vous pouvez maintenant exécuter le crawler pour obtenir les données et exporter les donénes vers Excel, CSV, HTML ou base de données.

Consultez ce tutoriel complet pour avoir un guide étape par étape.

Conseils pour le web scraping sur Twitter

Lorsque vous vous lancez dans le scraping de données sur Twitter, il est important de garder à l’esprit quelques conseils et bonnes pratiques afin d’optimiser votre processus et de vous conformer aux politiques de la plateforme.

- Définissez clairement les objectifs de votre projet de scraping et les données dont vous avez besoin. Cela vous permettra d’affiner vos requêtes et donc choisir le bon modèle qui correspond justement à votre besoin.

- Profiter des fonctionnalités de “Programmer l’exécution de tâches” pour suivre de près les mises à jour et les récolter à temps.

- Demander un essai gratuit de Octoparse premium pour tester la tester la solution.

Pour finir, on peut discuter sur un sujet auquel s’intéressent beaucoup de personnes :

Est-il légal de scraper Twitter ?

D’une manière générale, il est légal d’extraire et d’exploiter les données publiques. Cependant, vous devez toujours respecter la politique de protection des droits d’auteur et la réglementation sur les données personnelles. L’utilisation des données que vous avez extraites relève de votre responsabilité et vous devez prêter attention à la législation locale. Si vous avez toujours des doutes sur la légalité, vous pouvez essayer l’API de Twitter.

En conclusion

Pour exploiter pleinement le potentiel de Twitter, l’étape préliminaire consiste à récupérer l’ensemble des tweets pertinents pour votre projet. À cet effet, Octoparse s’avère être un outil puissant permettant de récolter efficacement ces informations depuis la plateforme.

Le processus de scraping de Twitter n’est pas particulièrement difficile grâce aux riches modèles de web scraping mis à disposition, aussi bien sur le site officiel d’Octoparse que dans le logiciel lui-même. Ainsi, même les débutants peuvent rapidement mettre en place des tâches de scraping opérationnelles.

Cependant, dans le cas où votre projet nécessiterait des fonctionnalités au-delà de ces modèles standards, vous avez également la possibilité de créer une tâche de scrapingà partir de zéro. Pour assurer le succès et la pérennité de cette approche, il est primordial de bien définir vos objectifs et de mettre en place des mécanismes de sauvegarde robustes.

En suivant ces étapes, vous serez en mesure d’exploiter efficacement les données Twitter pour les besoins de votre projet, tout en vous conformant aux bonnes pratiques en matière de scraping.