De nos jours, le crowdfunding, ou financement participatif, s’est rapidement imposé comme une source très précieuse pour analyser le marché et surveiller la concurrence. Ulule, l’une des plateformes de financement les plus connues en Europe, regroupant beaucoup de campagnes dans divers secteurs, de la technologie à l’art ou à la nourriture, nous en donne un aperçu clair des tendances du moment, y compris des comportements du public et des stratégies utilisées par les porteurs de projets créatifs.

Dans cet artice, nous vous présentons les méthodes de collecter de données rapidement tel que les montants récoltés, les détails des projets, les dates ou encoreles profis des créateurs, vous pouvez mieux obtenir les infos utles pour votre étude de marché ou l’analyse stucturé avec Octoparse.

Pourquoi on scrape Ulule ?

En collectant les données des projets en financement sur Ulule, vous pouvez élaborer des rapports de marché pour anticiper les tendances, identifier les partenaires potentiels. Scraper Ulule devient ainsi votre outil stratégique pour ajuster les campagnes marketing du financement participatif.

Il y a plusieurs professionnels qui ont besoin d’exploiter ces données :

- Les investisseurs

- Les entrepreneurs et startupers

- Les spécialistes du marketing et de la veille

- Les analystes en marché et chercheurs

- …

Quoique le but de votre recherche du crowdsourcing, vous pouvez toujours trouver des idées innovantes ou étudier les tendances économiques ou sociales en vous basant sur l’extraction en temps réel, ce qui vous permet d’avoir une vision stratégique plus éclairée.

Scraper Ulule sans coder : l’outil à ne pas manquer

Octoparse vous propose une interface utilisateur intuitive, il est possible de faire du scraping facilement et rapidement. Par quelques clics, vous pouvez définir votre workflow, extraire les infos cibles et automatiser la récupération de données en masse.

C’est une solution idéale pour tout professionnel qui veut tirer parti des données disponibles sur Ulule ou les autres plateformes du financement, sans besoin de compétences en programmation : vous pouvez gérer aussi les contenus dynamiques, contourner certains mécanismes anti-scraping, etc.

Ulule dispose d’une structure de pages assez claire : les projets sont généralement organisés avec des sections bien distinctes : description du projet, montant récolté, nombre de contributeurs, échéance et profils des porteurs de projets. Ces éléments sont souvent intégrés dans des pages dynamiques qui nécessitent une stratégie de scraping adaptée. C’est là qu’un scraper sans code comme Octoparse devient un véritable atout.

Les approches efficaces de web scraping en utilisant Octoparse

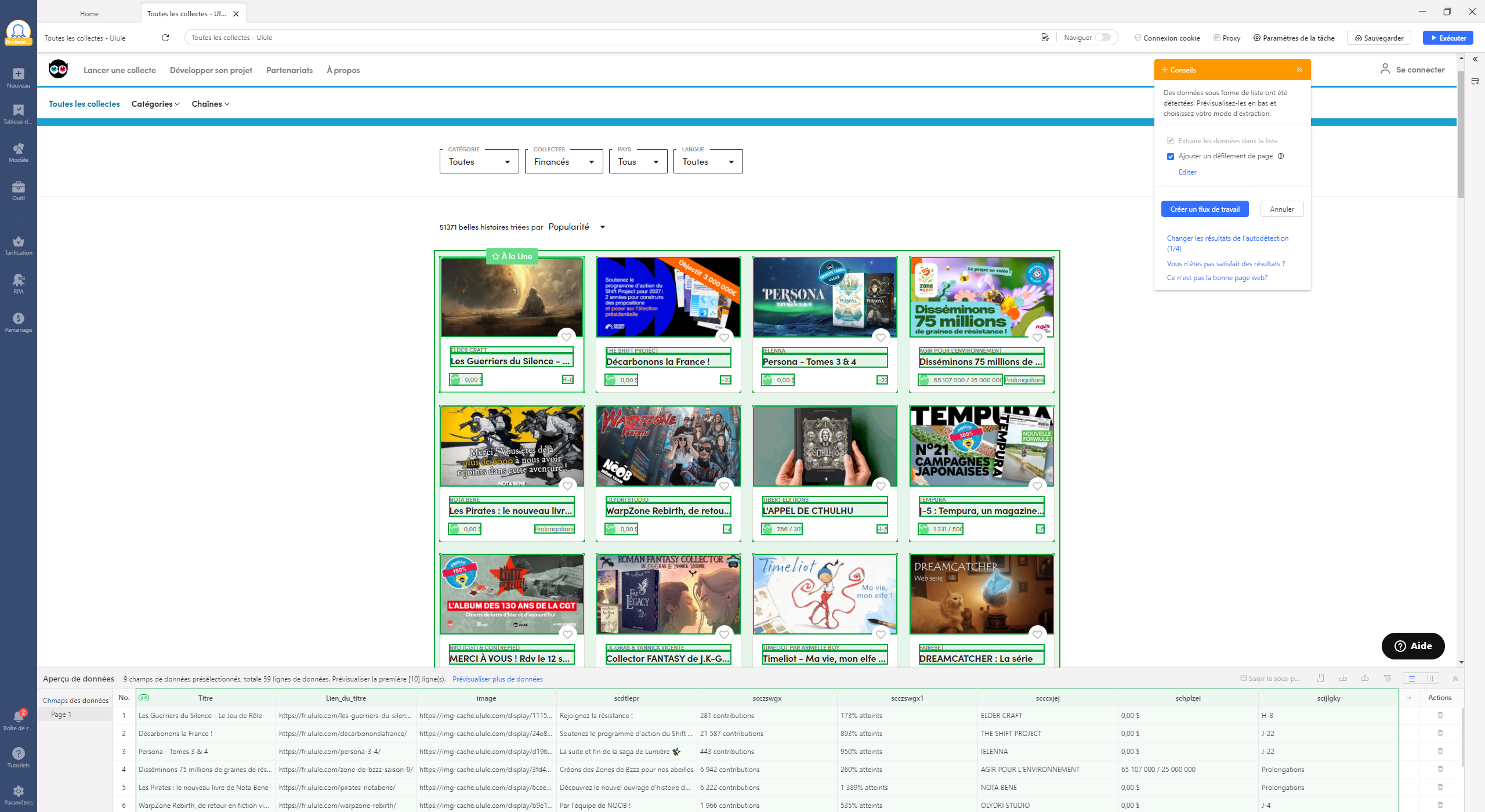

Entrez votre l’URL des liste de projets sur Octoparse

Tout d’abord, entrez le lien de la liste désirée que vous souhaitez analyser dans Octopqrse. Une fois l’adresse collée dans le champ dédié, l’outil charge automatiquement la page et y accède pour préparer la collecte des données. Cette étape simple permet d’accéder rapidement aux informations visibles sur la plateforme.

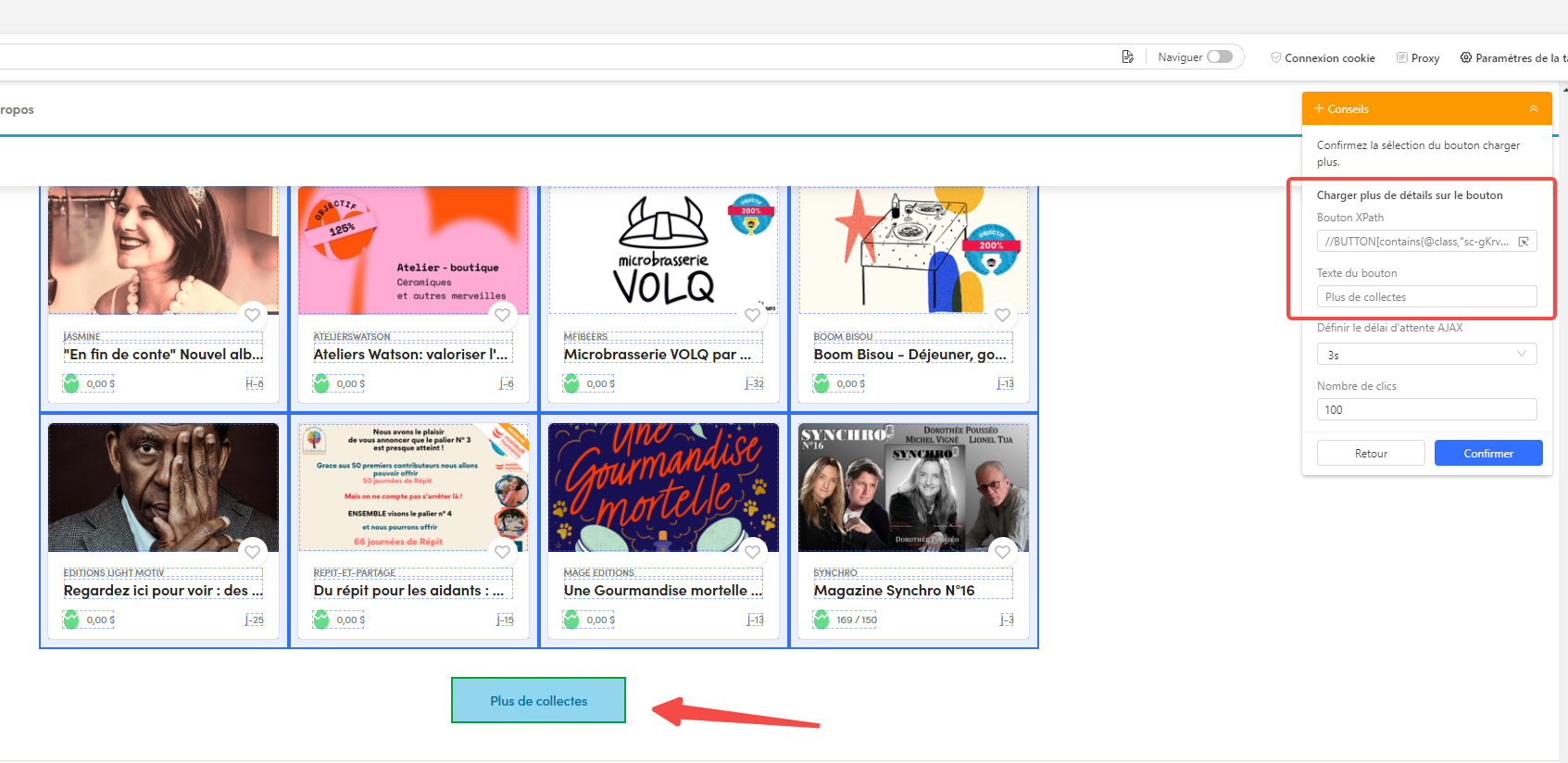

Personnaliser le flux de travail avec le bouton Plus de collectes

Notez que la façon de la pagination sur l’Ulule est liée au bouton « Plus de collectes ». Il faut ajouter les étapes au flux de travail pour cibler précisément les données dont vous avez besoin dans les parties suivantes. N’oubliez pas de définir le nombre de répétitions pour tourner la page dans l’option.

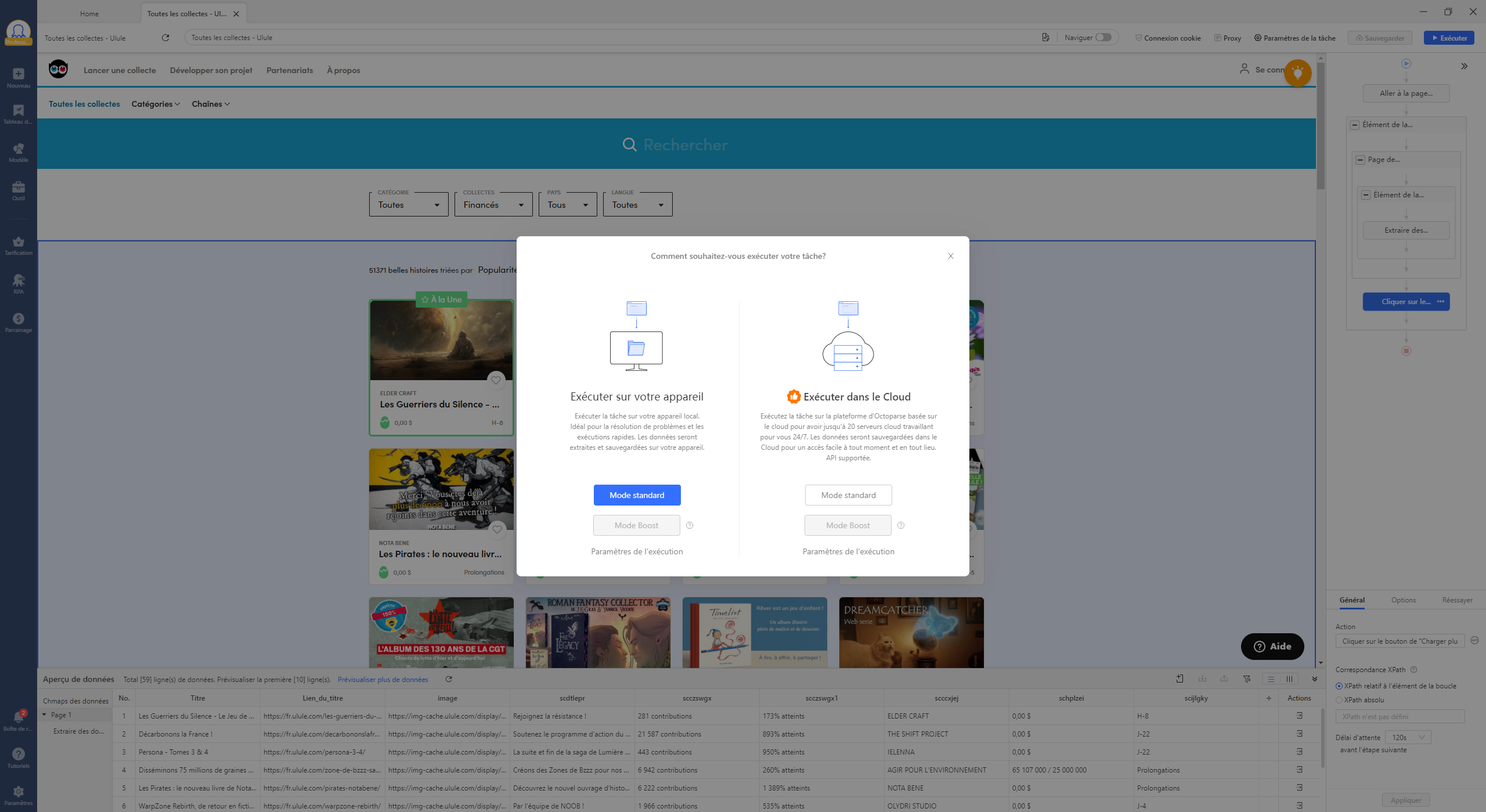

Lancer le crawler et télécharger les données de l’Ulule

Enfin, lorsque votre configuration est prête, il ne reste plus qu’à lancer le crawler en exécutant localement ou en nuage. Octoparse parcourra la page, suivra les liens si nécessaire, et extraira automatiquement toutes les données structurées selon vos paramètres. Une fois le processus terminé, vous pouvez télécharger les données dans un format pratique, comme Excel ou CSV, pour les analyser et les utiliser dans vos stratégies de marché ou de veille concurrentielle.

Voici quelques conseils qui peuvent aider votre crawler personnalisé à se développer plus rapidement :

Lire l’article : Gain de temps avec Octoparse pour accélérer votre processus de web scraping.

Conclusion

Transformer les sites web vers Excel, CSV, Google Sheets ou base de données.

Auto-détecter les sites Web et extraire les données sans aucun codage.

Scraper les sites populaires en quelques clics avec les modèles pré-construits.

Ne se trouver jamais bloqué grâce aux proxies IP et à l’API avancée.

Service Cloud pour programmer le scraping de données.

En utilisant Octoparse pour la recherche sur Ulule, vous pouvez profiter de nombreux avantages. Par exemple, avec la fonction d’auto-détection, c’est assez simple de récolter des informations même pour des utilisateurs n’ayant pas de connaissance en programmation.

Vous pouvez ainsi automatiser l’extraction des données structurées, économiser du temps et obtenir des résultats de qualité. N’hésitez pas, nous vous invitons maintenant à mieux exploiter Octoparse pour maximiser la valeur analytique des données de crowdfunding ! Ding !