Pour l’instant, la performance à récupérer efficacement les données en ligne constitue le véritable enjeu à l’égard de la stratégie pour les entreprises. Octoparse, adapté spécifiquement à vos besoins, se positionne comme votre propre crawler du web et vous offre une solution pertinente pour l’extraction des données souhaitées, par exemple dans le domaine du e-commerce, de la recherche universitaire ou de l’analyse du marché numérique, etc.

À travers cet article, nous vous proposons les méthodes pour bien profiter des avantages de l’Octoparse par l’introduction de quelques astuces usuels en optimisant vos projets de scraping et ainsi en boostant la productivité de vos données.

Les astuces du web scraping avec Octoparse

Pendant la création de votre flux de travail

Normalement, il y a un flux de travail montré dans la partie droite de l’écran dès que vous avez cliqué sur les éléments ou fini l’auto-détection avec Octoparse, mais, à ce moment-là, il est possible de trouver des façons plus efficaces pour mieux vérifier votre workflow précis :

Identifier clairement les données à extraire

Les éléments que vous voulez régler sont fondamentaux à définir avant toute chose. Par exemple, pour extraire les données comme les avis des clients d’une plateforme d’achat en ligne, il faut choisir les commentaires tout d’abord, et après les éléments comme le nom, les tags du produit, le prix ou encore la date. Les données peuvent construire le cadre analytique, c’est-à-dire qu’un aperçu de donnée va être différencié par votre choix et réduire le temps de la modification.

Avec Octoparse, il est possible de cliquer sur l’écran les éléments directement tels que le texte/l’URL, le HTML interne/externe ou les données dans la boucle. Les champs de données ciblées avant la collection vous permettent d’éviter des erreurs, surtout pour le cas où vous choisissez selon l’importance de l’ordre énuméré.

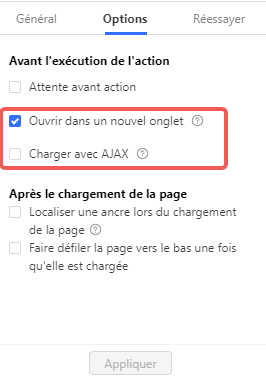

Configurer l’ouverture de la nouvelle page

Avez-vous rencontré la situation où il faut parcourir les contenus après avoir cliqué sur le bouton suivant ? Ici, nous devons faire attention aux façons d’ouverture de la fenêtre. Il y a des options de la configuration requise pour vous choisir quand on a besoin de continuer l’action : ouvrir dans un nouvel onglet ou charger avec AJAX. Vous pouvez cliquer sur la page dans votre navigateur et vérifier la page d’ouverture dans un nouvel onglet ou sur la page existante, cela vous permet de configurer les paramètres de l’action dans un flux de travail. S’il est optionnel avec AJAX, vous pouvez aussi sélectionner le délai d’attente pour prolonger le chargement de la page.

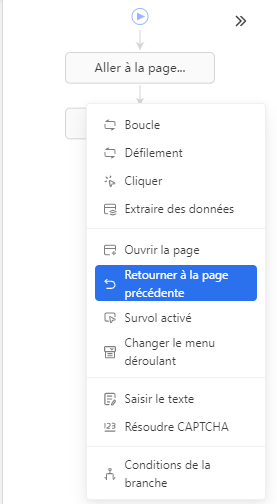

Faire le retour à la page précédente

En principe, lors du scrap de sites Web, l’extraction de données se fait souvent depuis la page de résultats de recherche (la page liste) ainsi que la page détail de chaque produit. Cependant, si cette dernière est bloquée et que l’Octoparse ne peut revenir sur une page liste (exemple : lorsqu’il est impossible de rouvrir dans un nouvel onglet la page détail), nous sommes obligés de séparer la tâche en deux parties.

En ce cas-là, il faut ajouter l’action de retourner à la page précédente (comme indiqué dans l’image ci-dessous) dans le flux du travail pour réduire les étapes non nécessaire, sinon, il y aura des duplications vides dans la page liste après l’obtention de la première ligne de données.

Fermer le pop-up dans Octoparse

Les fenêtres pop-up sont souvent perçues comme gênantes et distractives lors de la création de tâches. Il y a deux façons d’éviter l’apparition du pop-up des sites web : vous pouvez tout d’abord le fermer manuellement par clics sur la croix pour fermer la fenêtre après avoir désactivé le mode de navigation. La deuxième option permet d’automatiser la fermeture en ajoutant l’action “cliquer sur le bouton” dans le panneau de conseils. N’oubliez pas de définir un délai d’attente AJAX pour garantir un timing optimal de la fermeture.

Après avoir testé votre projet

N’avez-vous pas vu le résultat prévu ? Il y a des données redondantes sur votre Excel ? Bien que l’on fasse une vérification précise pour créer le flux de travail, il est possible d’extraire les données doublées ou vides quelques fois. Quel type de négligence se produit fréquemment ? Comment localiser les erreurs et les modifier pendant notre collection ?

Régler la répétition des données

Les données répétées peuvent fausser vos analyses et alourdir vos bases. Généralement, le XPath de pagination est généré automatiquement et si dans votre cas, vous constatez que Octoparse réutilise les données d’une même page sur plusieurs pages, alors quelques ajustements seront nécessaires.

Octoparse vous propose des façons de détecter et de supprimer ces redondances dès l’extraction. Premièrement, vous pouvez vérifier le XPath de pagination généré automatiquement, par exemple, modifier précisément le bouton de la page suivante.

Le délai d’attente AJAX court pour la pagination risque peut-être d’entraîner la répétition des données, il est préférable de sélectionner le délai d’attente AJAX plus long lors de l’extraction. En plus, il faut éviter de régler dès que possible les noms identiques pour les champs de données lors de la boucle à travers la liste d’articles sur Octoparse.

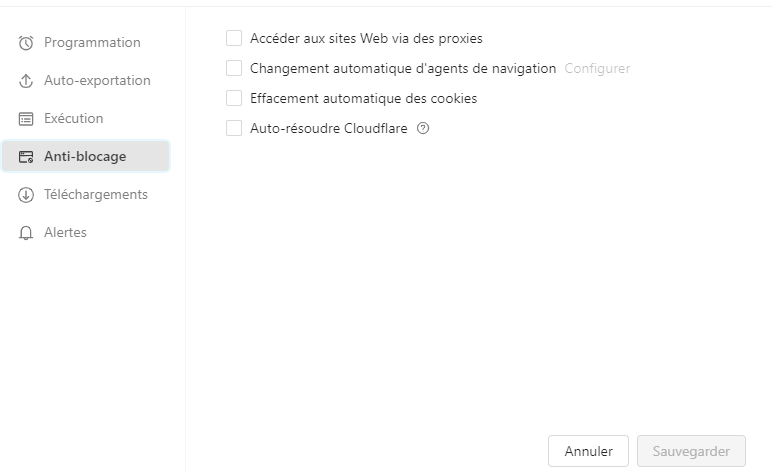

Éviter les blocages sur les sites cibles

Certains sites Web sont sensibles au web scraping et prennent des mesures anti-scraping en bloquant l’IP pour éviter l’activité de provoquer une interruption de service.

Octoparse vous propose plusieurs méthodes pour contourner les blocages. C’est facile de configurer les proxies manuellement, par exemple, vous visitez le site web par les proxies externes – depuis un pays spécifique. Faites attention, cette façon d’utilisation des proxies IP s’exécute uniquement localement.

D’un autre côté, on vous conseille de changer les agents des sites web visités, il s’agit d’une chaîne de caractères utilisée par un site web pour identifier le type d’appareil utilisé pour accéder à sa page. Lorsqu’un site est scrappé fréquemment avec le même agent utilisateur, il devient plus susceptible d’être reconnu comme un robot de scrappage. Cette fonctionnalité vise donc à minimiser les risques de blocage.

Améliorer la qualité du scraping

Avez-vous déjà exporté les données désirées ? Voulez-vous bien structurer les données collectées ? Avez-vous besoin d’optimiser les processus de scraping ? Nous vous proposons les méthodes ci-dessous pour vous automatiser et exploiter les données de manière flexible et efficace :

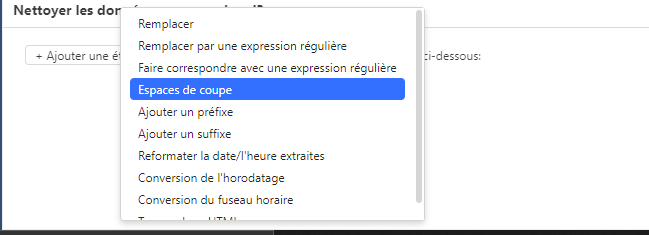

Affiner les résultats efficacement

Comme l’image l’indique ci-dessous, les résultats sont affichés dans la partie de l’aperçu de données en temps réel. Vous pouvez affiner les données, normaliser les formats ou ajouter des préfixes spécifiques par nettoyage des données dans les choix sur Octoparse dans n’importe quel site. Cela vous aide à structurer vos données de manière lisible et exploitable, il n’y a pas de besoin de reformater le champ après l’exportation.

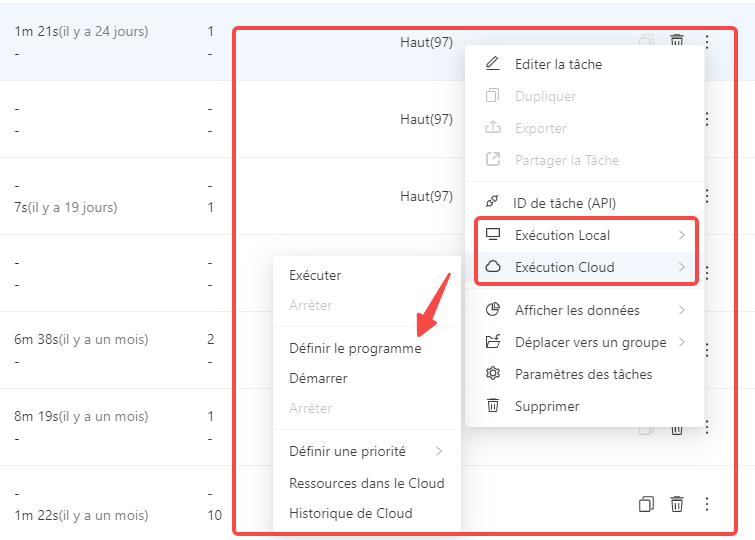

Automatiser vos tâches par la planification

Vous voulez pas toujours attendre les résultats avant l’écran ? Octoparse vous offre un gain de temps par la programmation des extractions régulières — quotidiennes, hebdomadaires ou selon votre propre cadence, par exemple toutes les 1 minute, 5 minutes, 10 minutes ou 30 minutes, sans besoin d’intervenir manuellement à chaque fois.

Entrez dans la page du Tableau de bord, puis choisissez la tâche ciblée et cliquez sur Exécution Locale ou Cloud. Ensuite, vous pouvez définir votre programmation en réorganisant les paramètres.

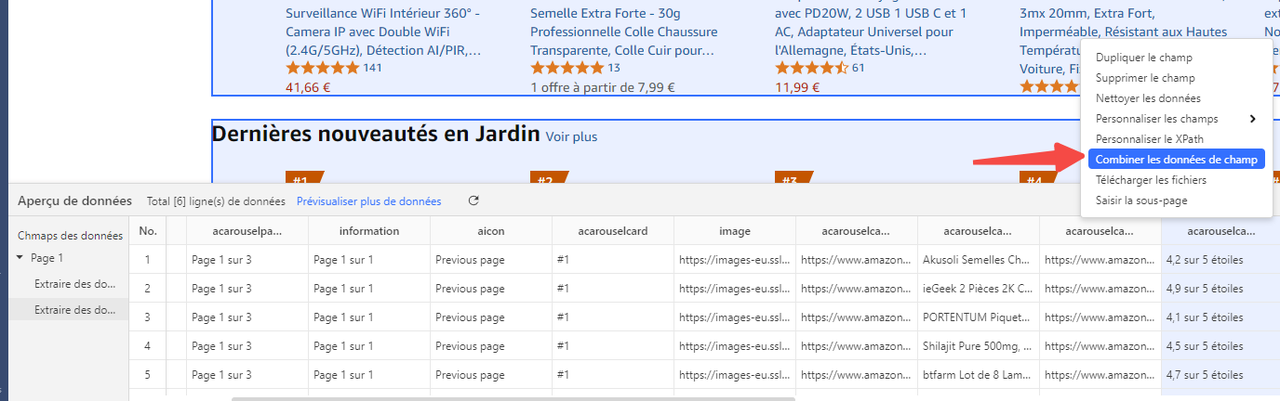

Assembler plusieurs lignes en un seul enregistrement

Parfois, il ne suffit pas d’exporter les résultats par lignes différentes, par exemple, c’est nécessaire d’exporter la description, la date de publication dans la même colonne. C’est indispensable d’intégrer les données des lignes différentes après avoir scrapé les sites pour adapter certains formats voulus. Octoparse vous permet de regrouper ces données en une structure cohérente en cliquant sur “combiner les données de champs” dans l’aperçu de données.

Utiliser l’API pour industrialiser le processus

Octoparse vous propose également l’API d’exporter les données du nuage pour des besoins à grande échelle et d’exporter automatiquement des données vers votre base de données (Google Sheets, MySQL, SQL Server, etc.), ce qui vous permet d’automatiser les tâches simultanément. Vous pouvez exporter les résultats en formats selon votre choix (Excel, CSV, JSON, HTML, Xml), tout en gardant le contrôle sur les paramètres. C’est la façon la plus idéale pour les utilisateurs cherchant à intégrer le scraping dans la chaîne automatisée en masse.

Conseils pour fluidifier le workflow

Voilà, Octoparse vous propose aussi des solutions d’organisation pour accélérer considérablement le processus d’une gestion simplifiée de vos activités de scraping.

Centraliser vos projets pour mieux gérer vos données

Centraliser vos projets dans un seul endroit unique permet un suivi d’avancement plus précis, une gestion simplifiée, des mises à jour aisées et l’utilisation des informations à long terme devient plus efficace. Grâce à la création de votre propre agrégateur, vous pouvez avoir une idée d’ensemble claire sur toutes vos activités de scraping, vous offrant ainsi un niveau supérieur de vue sur votre stratégie et vos performances.

Gagner du temps grâce aux modèles

Choisir le modèle préféré, et puis exporter vos données souhaitées, simplement !

Généralement, ayant plus de 500 modèles prédéfinis pour les sites populaires du monde entier, Octoparse vous propose beaucoup de choix d’extraction par rapport à l’industrie variée. Il y a deux types de modèles sur Octoparse, y compris le modèle OTD configuré par le mode avancé et le modèle JavaScript/Python écrit spécialement pour contourner les anti-grattage des sites. Notez que le modèle OTD s’exécute localement et aussi dans le Cloud, et au contraire que le modèle JS/Python ne s’exécute qu’en nuage.

Vous pouvez cliquer sur le lien ci-dessous de Google Maps Contact Scraper pour expérimenter l’utilisation du modèle populaire :

https://www.octoparse.fr/template/google-maps-contact-scraper

Nous proposons aussi un service de personnalisation et de révision des modèles. Si vous avez besoin d’un nouveau modèle, avec lequel vous n’avez qu’à saisir quelques paramètres et attendre que les données soient extraites, vous pouvez aussi nous consulter sur le service.

Conclusion

En somme, maîtriser Octoparse, c’est bien plus que savoir extraire des données. C’est apprendre à structurer les projets, tirer parti des fonctions de l’auto-détection et optimiser son flux de travail. Avec les bons réglages, vous gagnerez du temps, améliorerez la qualité de vos données et renforcerez la pertinence de vos analyses.

Pourquoi attendre ? Téléchargez Octoparse et passez à la vitesse supérieure : une collecte plus rapide, plus intelligente et résolument tournée vers la stratégie.