Web scraping, également connu comme web crawling, (Web) data extraction, data mining, screen scraping, est le processus de collecte de grandes quantités de données du web, puis de sauvegarde dans un fichier, une base de données, etc. Allons plus loin dans l’étude du web scraping.

Il est estimé qu’Internet a doublé de taille chaque année depuis 2012. Qu’est-ce que cela signifie ? Oui, il y a beaucoup de données. Ces données pourraient vous aider considérablement si vous savez quoi en faire. Maintenant, la question se résume à comment collecter les données ?

Si vous vous contentez de naviguer de site en site, de choisir les informations que vous voulez, puis de les copier et coller dans un autre fichier, ce serait beaucoup trop long et fastidieux bien que ce soit le seul choix pendant longtemps avant que le robot d’exploration automatique du Web ne soit disponible. La plupart des gens ne sont pas assez experts pour construire un crawler à partir de rien, et n’ont pas non plus le budget suffisant pour acheter les données, d’où l’utilisation d’outils de scraping web (voir Top 3 Web Scraping Tools Review pour plus d’informations) comme Octoparse pour le scraping de données.

Toutes les données visibles sur le Web peuvent être récupérées, même les sites Web nécessitant des informations de connexion si vous disposez des informations d’identification. Voici comment fonctionnent la plupart des outils d’exploration du Web : ils ouvrent la page Web pour la visiter, puis extraient automatiquement les données sélectionnées de centaines ou de milliers d’URL en même temps ou selon un calendrier.

Vous vous demandez peut-être pourquoi. Quel est l’intérêt, et quelles sont les choses que vous pouvez faire avec ces données extraites ? Ma réponse est qu’une bonne décision, une bonne stratégie ou un bon plan est pris en fonction de la quantité de données dont vous bénéficiez.

Alors, comment pouvez-vous utiliser les outils de scraping web ? Voici trois Façons Typiques de prendre des décisions dans le domaine du marketing.

Génération de leads

Il existe de nombreuses tactiques que vous pouvez essayer pour générer un lead en fonction de la nature de votre activité. Les médias sociaux, les communautés comme Quora, les conférences, le guest posting, les publicités payantes, les leads magnets, etc. Et comment le web scraping aide-t-il à générer des leads ?

Par essence, un lead peut être facilement défini comme des coordonnées qui correspondent à un profil. Si vous avez un nouveau SaaS médical cloud pour les anesthésistes, vous avez besoin d’une liste d’anesthésistes ; si vous avez un nouveau produit que vous voulez persuader tous les agents immobiliers d’utiliser, vous avez besoin de leurs informations.

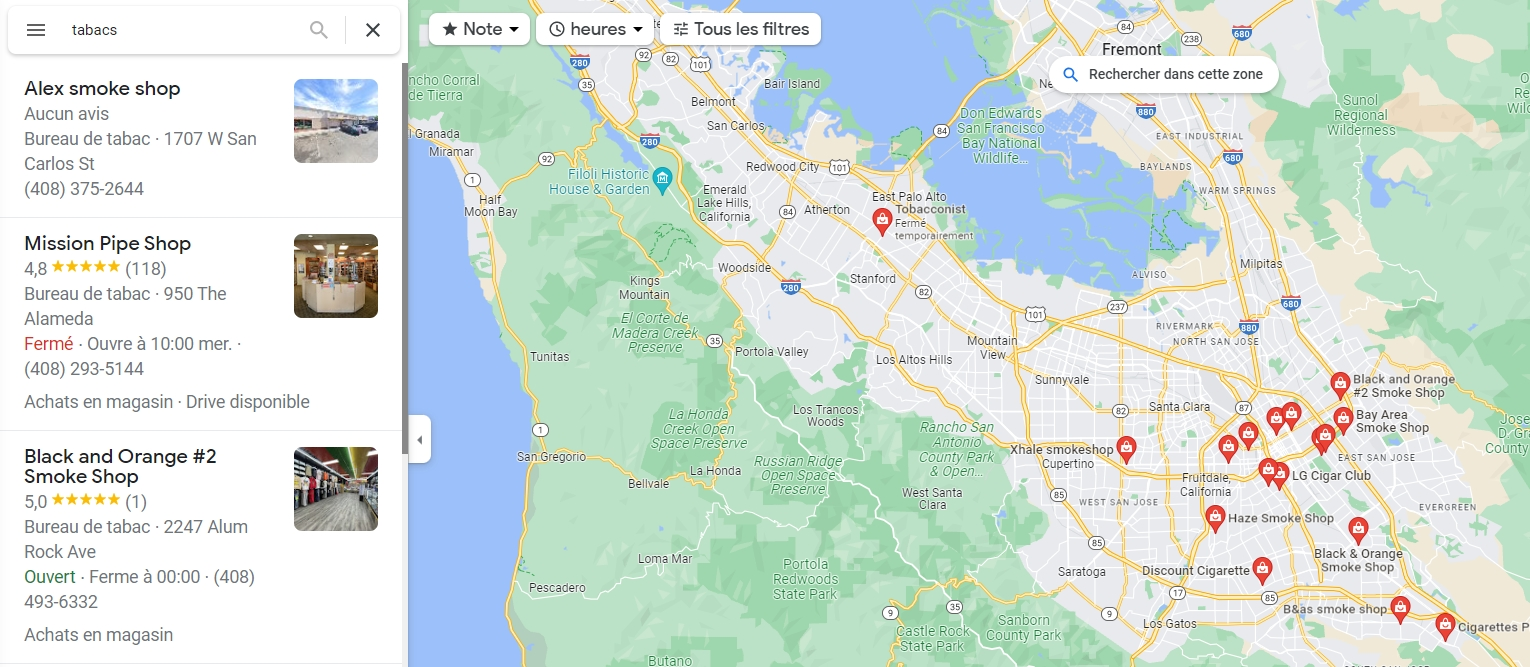

Un scraper web pourrait collecter automatiquement les informations vous concernant : nom, localisation, ville, code postal, numéro de téléphone, site web, etc.

Et vous pouvez qualifier ces leads en recherchant ou en filtrant les données extraites par mots-clés, ou tout autre critère pour trouver vos personas exacts. Donc ce ne sont pas seulement des leads, ce sont des leads qualifiés. C’est une mine d’or.

Grâce à ces informations de contact récupérées, vous pouvez développer votre base de clients et maintenir un flux constant de prospects dans votre chaîne de vente.

Toutes les informations sont disponibles en ligne si vous savez où chercher. Deux bonnes ressources pour obtenir ces informations sont les Pages Jaunes et Yelp. Voici les liens qui vous permettront d’apprendre à extraire les données de ces deux sites Web :

Études de marché

L’étude de marché fait partie de la diligence raisonnable pour les propriétaires d’entreprise. Un scraper Web peut extraire les données nécessaires dans des formats structurés de sites d’études de marché, d’annuaires, de sites d’information et de blogs sectoriels. Vous pouvez ainsi obtenir des informations sur les opportunités et dresser une liste exhaustive de la concurrence directe et indirecte, ou de la clientèle potentielle (sur la base de vos buyer personas) dans une région géographique donnée, etc.

Par exemple, une société immobilière pourrait utiliser les données extraites des enchères, des ventes et des prix pour se tenir au courant des tendances du marché et des structures de prix concurrentielles en temps réel.

Optimisation des Moteurs de Recherche

Si vous avez un site web, quel qu’il soit, qu’il s’agisse d’un produit ou d’un service, qu’il s’agisse de quelque chose que tout le monde pourrait utiliser ou conçu pour une petite niche ; si vous voulez faire de la promotion en ligne et utiliser des données, vous devez obtenir plus de trafic pour développer votre marché.

Il existe différents moyens d’obtenir du trafic, y compris le trafic direct, organique, par référence, social et payant. Pour la plupart des sites web, il provient de la recherche organique. Il existe plusieurs façons de booster votre trafic de recherche organique, mais elles tournent toutes autour de l’optimisation des moteurs de recherche (SEO).

Prenons l’exemple d’Octoparse et voyons ce que vous pourriez faire avec le web scraping pour la gestion et l’analyse du SEO.

Tout d’abord, nous pourrions suivre le classement des pages dans le temps en extrayant les pages de résultats de divers moteurs de recherche pour des mots clés donnés.

Nous savons qu’Octoparse est un outil de scraping web et je veux savoir où Octoparse se classe pour chaque mot-clé recherché avec le “web scraping”. Je cherche donc à extraire les résultats de recherche en entrant les mots-clés ciblés (pour plus d’informations, reportez-vous à la section “Entrer le text“), puis j’exporte ces données dans Excel.

En cherchant à savoir ce qui se classe avant Octoparse, je renonce à certains mots-clés, considérant qu’il peut y avoir des sites web pratiquement imbattables.

Deuxièmement, pour être mieux classé et obtenir plus de clics, je me tourne vers la concurrence directe et je vois quels sont les mots clés et les expressions pour lesquels ils sont classés et qu’ils recherchent. Une analyse approfondie du contenu de leur site peut me donner un aperçu des titres, des mots-clés, des descriptions et des liens.

Je pourrais alors prendre des mesures pour générer des articles de haute qualité afin de générer du trafic sur les moteurs de recherche.

Troisièmement, les classements changent tout le temps. Je dois garder un œil sur les données mises à jour afin de savoir si je progresse, si je diminue ou si je reste au même niveau. La plupart des web scrapers proposent un service de cloud computing pour obtenir des données en temps réel. Par exemple, Octoparse Cloud Service permet aux utilisateurs de programmer les crawlers pour obtenir les données mises à jour au fil du temps. Vous pouvez vous référer à Comment obtenir du trafic organique des moteurs de recherche vers votre blog pour plus de conseils sur la génération de trafic.

Il existe de nombreuses autres manières d’utiliser les outils de scraping web, comme la recherche d’emploi et le recrutement, la gestion financière, etc. Je n’en ai mentionné qu’une petite partie, mais j’espère que cela vous donnera quelques idées sur la manière d’utiliser les données récupérées. Avec les grandes quantités de données disponibles en ligne, vous avez besoin d’une solution simple pour les collecter et les passer au crible.

Un outil de scraping vous permet de bénéficier d’un scraping web automatique sans avoir à installer quoi que ce soit ou à apprendre le codage.