Quand a-t-on besoin de trouver des liens de site ?

Avez-vous déjà rencontré des situations où trouver des liens nécessaires, comme des liens manquants dans une campagne SEO ou des données incohérentes après une extraction massive ? Lorsqu’on doit aspirer des milliers d’URL en masse, comment éviter que des liens importants soient oubliés ou mal identifiés ?

Quels que soient les analystes SEO, les chercheurs des marketing digital ou les entrepreneurs, on a toujours besoin de trouver des liens de sites ciblés pour analyser la structure globale, alimenter la campagne de netlinking et réaliser la copie hors ligne. Les liens, ce sont les sources clés stratégiques pour toute démarche de veille concurrentielle du marché. Dans cet article, nous vous présenterons les TOP 14 extracteurs pour trouver des liens de la page.

14 meilleurs outils pour aspirer les URLs

Outils no-code du scraping de données

Octoparse est un outil de web scraping puissant et gratuit qui vous permet d’extraire du HTML interne/externe et des liens à partir de différents champs de balises. Il s’agit d’une solution sans code qui permet à tout le monde de récupérer des données sans écrire la moindre ligne de code.

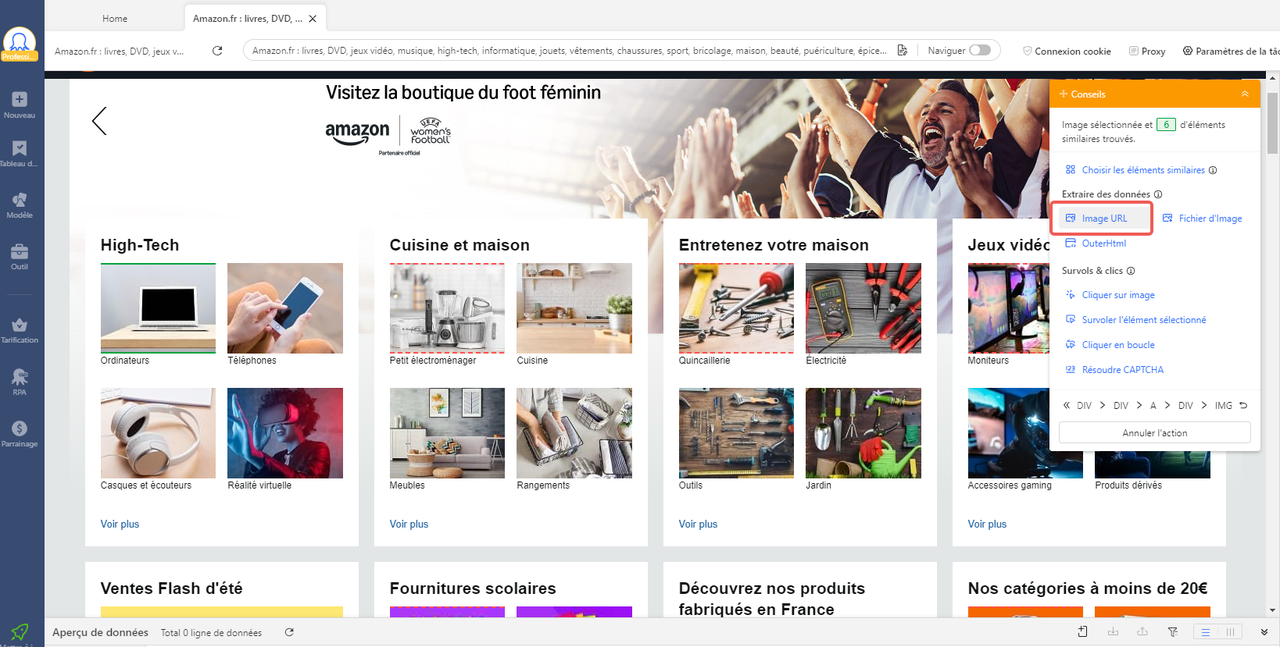

Les hyperliens sont des URL cliquables qui ouvrent de nouvelles pages ou vous dirigent vers de nouveaux sites Web. Lorsque vous obtenez des URL, vous pouvez accéder et télécharger le fichier ou l’image correspondant via ces liens. Pour extraire les liens avec Octoparse, vous n’avez qu’à cliquer sur vos données cibles et à sélectionner Lien dans le panneau Conseils.

Cet outil est fréquemment utilisé dans l’extraction de liens des images. Il vous suffit de cliquer sur l’image et puis de sélectionner Image URL dans le panneau de conseils. En tant que logiciel de web scraping, Octoparse est loin d’être justement un extracteur de lien. Il peut extraire tous les éléments depuis des pages Web, y compris texte, tableau, lien, image, etc. Quelques étapes sont suffisantes pour créer vous-même un web scraper avec cet outil totalement no code.

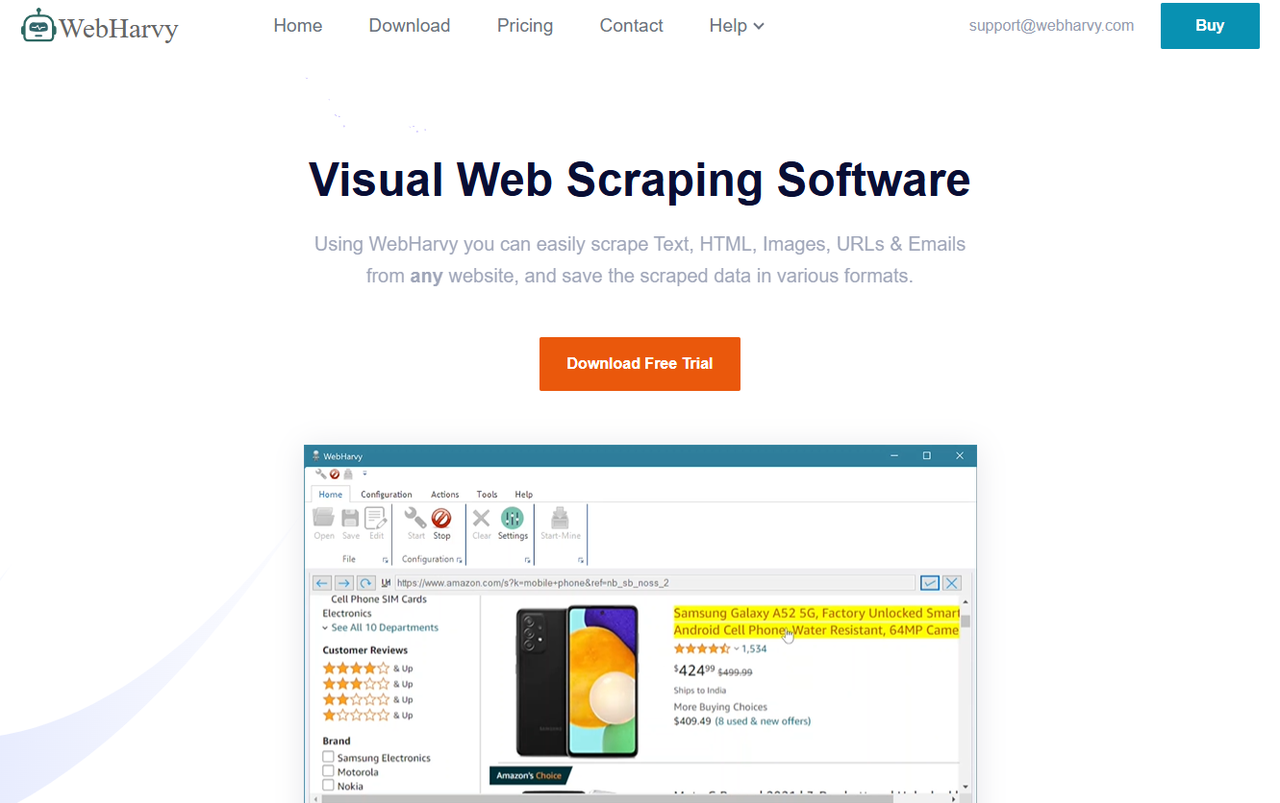

WebHarvy

WebHarvy est un logiciel de scraping web par pointer-cliquer qui permet aux utilisateurs d’extraire des données web, y compris des URL, en toute simplicité. Lorsque vous scrapez des URL à l’aide de WebHarvy, vous pouvez utiliser son expression régulière prédéfinie pour obtenir des liens à partir du code HTML plutôt que d’en écrire une vous-même.

Content Grabber Content Grabber est un logiciel destiné à l’extraction de données à grande échelle. Il permet d’aspirer un site entier ou des pages spécifiques de manière automatisée, ce qui est utile pour collecter rapidement de grandes quantités d’informations structurées. L’outil offre des options avancées pour configurer les processus d’extraction, gérer de volumes importants de données, et exporter les résultats dans différents formats. Son utilisation est adaptée aux besoins de professionnels qui recherchent une solution fiable pour effectuer du scraping de manière régulière ou à grande échelle.

Extensions Chrome pour aspirer des liens

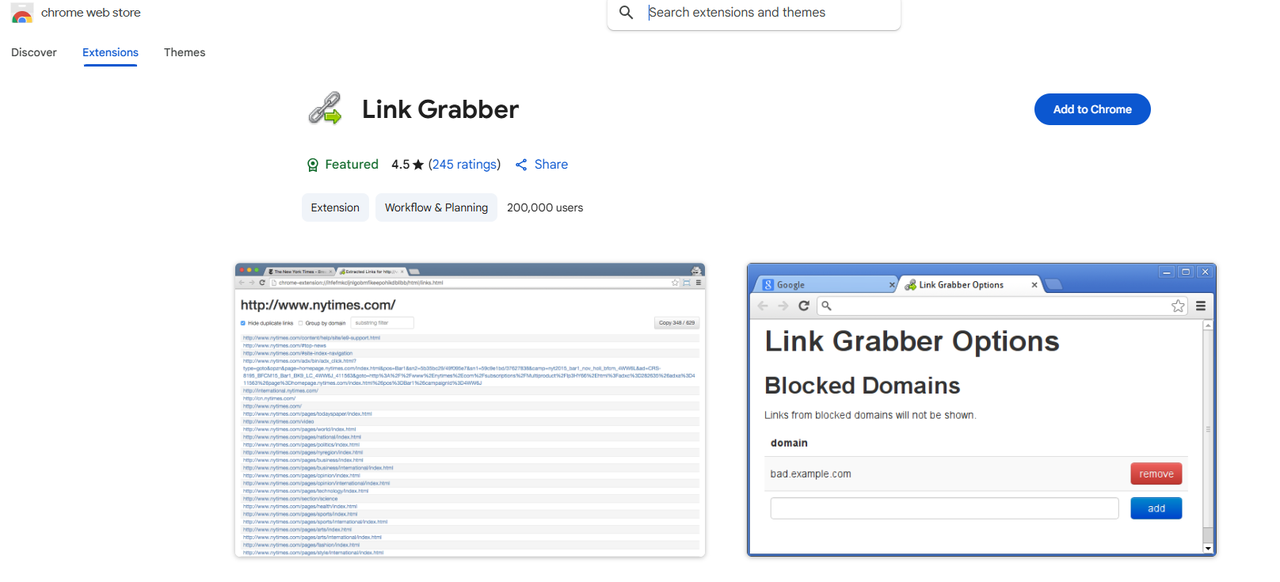

Link Grabber

Link Grabber est un extracteur, en particulier pour les liens hypertextes sur les pages HTML. Comme il s’agit d’une extension Chrome, il est léger et facile à utiliser. Il peut également filtrer les liens par correspondance de chaîne de caractères et regrouper les liens par domaine, ce qui vous permet de gagner du temps pour nettoyer les données extraites. Mais il ne peut extraire que des liens sur des sites web. Si vous avez besoin de plus de données comme du texte et des images, ce n’est probablement pas le meilleur choix.

Link Klipper

Link Klipper est l’un des extracteurs de liens les plus populaires du Chrome Web Store. Simple mais puissant, il vous permet d’extraire tous les liens d’une page web et de les exporter dans un fichier. Vous pouvez personnaliser une zone du site web et extraire tous les liens de cette zone en fonction de vos besoins. Toutefois, cette extension ne permet d’exporter toutes les données extraites que sous la forme d’un fichier CSV. Si vous avez besoin de stocker des données dans d’autres formats à des fins d’analyse, vous devez consacrer plus de temps à la conversion du format CSV.

Outils basés sur la programmation

Beautiful Soup (Python) Beautiful Soup est une bibliothèque Python populaire qui permet d’extraire des données de fichiers HTML et XML. Elle peut bien gérer un HTML mal formaté et fournit une API simple et intuitive pour naviguer et extraire des données de documents HTML. Si vous êtes familier avec le codage, il peut s’agir d’une méthode flexible et efficace. Voici un exemple de code qui montre comment Beautiful Soup récupère les liens d’un site web.

Scrapy (Python) Scrapy est un outil puissant et flexible d’exploration et de récupération de données sur le web, écrit en Python. Vous pouvez trouver dans Scrapy un ensemble complet d’outils pour l’extraction de données, y compris des liens. L’un des principaux avantages de Scrapy est qu’il est bien adapté aux tâches de scraping à grande échelle, qu’il prend en charge le crawling distribué et qu’il gère efficacement les scénarios complexes. Vous trouverez ci-dessous un exemple de code pour l’extraction de liens à l’aide de Scrapy.

Selenium (multi-langues) Selenium est connu comme un outil d’automatisation web utilisé pour tester des applications. Mais il peut également être utilisé pour des tâches de web scraping. Par rapport à d’autres bibliothèques Python, Selenium visualise le processus de scraping, ce qui facilite le débogage et la vérification des liens extraits. Cependant, en termes de vitesse de scraping, Selenium peut être relativement plus lent que Beautiful Soup ou Scrapy, en particulier pour les tâches de scraping à grande échelle.

Les plateformes pour l’application variée

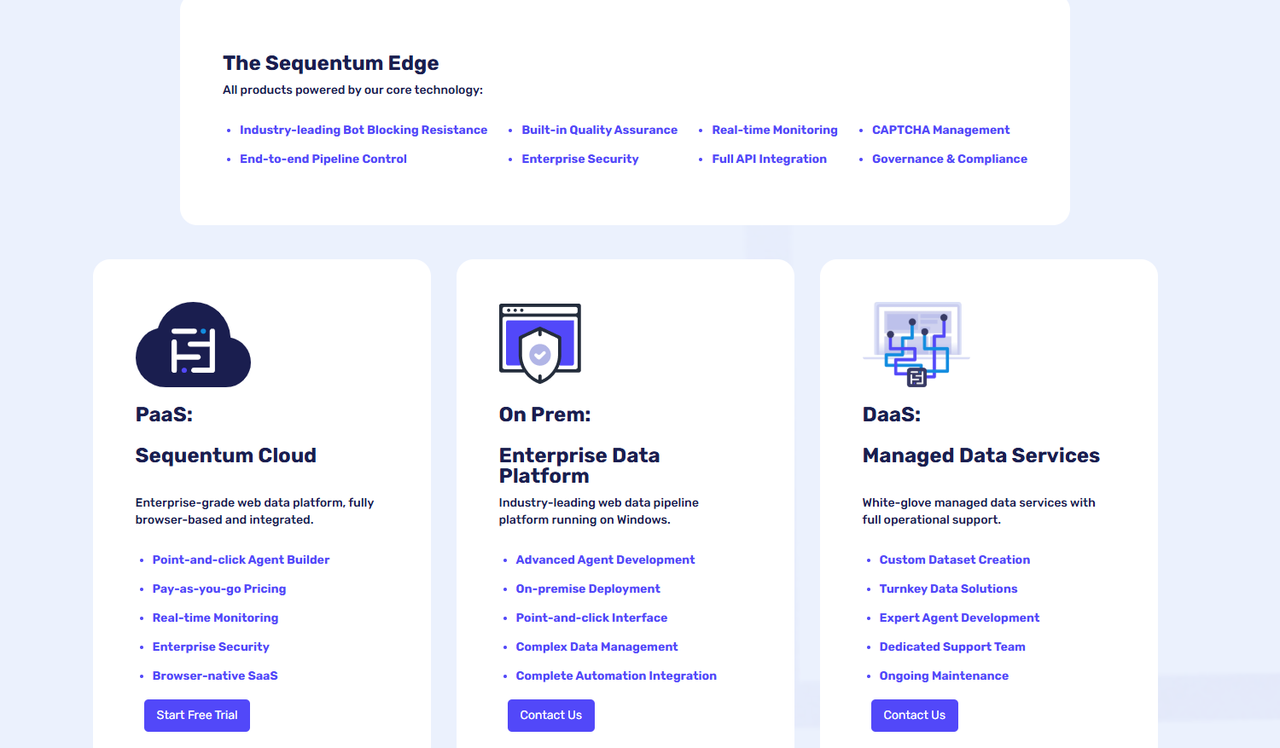

Bright Data

Bright Data est une société qui propose des services de collecte de données web aux entreprises B2B. Elle met à la disposition des utilisateurs divers outils et API pour la collecte de données web à des fins diverses. L’URL Scraper de Bright Data est prédéfini et vous pouvez l’utiliser pour collecter des URL à partir de sites de commerce électronique, de médias sociaux, de sites Web immobiliers, etc. Mais attention au coût. L’utilisation des services de Bright Data peut s’avérer coûteuse si vous avez des besoins de scraping importants ou intensifs.

Apify

Apify est également une plateforme de scraping web. Les utilisateurs peuvent y trouver des outils et des modèles de code prêts à l’emploi pour extraire des données de sites web. De nombreux extracteurs de liens sont conçus et téléchargés par des développeurs disponibles sur Apify, et la plupart d’entre eux sont conviviaux et vous permettent de gérer des tâches de web scraping sans connaissances approfondies en programmation. Toutefois, si vous n’avez aucune expérience en matière de codage, la courbe d’apprentissage risque d’être abrupte.

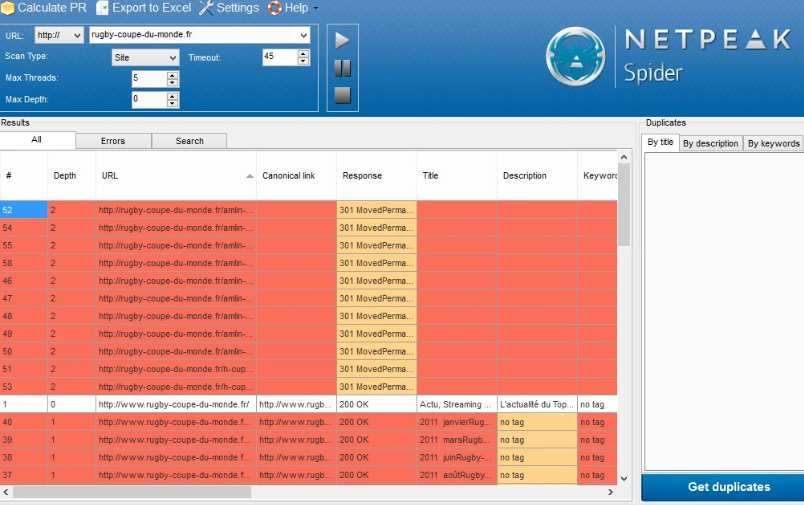

Netpeak Spider

Un outil SEO puissant permettant d’aspirer tous les liens d’un site web et de réaliser un crawling exhaustif. Il est idéal pour analyser la structure de liens internes et externes, détecter des erreurs, des redirections, ou des pages orphelines. Très utilisé dans le scraping de données de référencement pour aspirer rapidement un site entier.

ParseHub

ParseHub est une plateforme de web scraping qui permet d’extraire des liens et du contenu dynamique de sites web complexes. Elle dispose d’une interface utilisateur graphique qui facilite la configuration des projets de scraping, même pour des sites nécessitant une gestion particulière du contenu interactif ou chargé en JavaScript.

HTTrack

HTTrack est un logiciel open source permettant de télécharger une copie complète d’un site web pour une consultation hors ligne. Il facilite la récupération de toutes les pages, images, liens et autres éléments du site, afin de créer une copie locale utilisable ultérieurement.

GNU Wget

GNU Wget est un utilitaire en ligne de commande conçu pour télécharger du contenu depuis Internet. Il permet d’aspirer efficacement un site web entier ou une liste spécifique d’URL, en gérant la reprise des téléchargements en cas d’interruption.

Techniques pour optimiser le scraping de données

Pour maximiser l’efficacité du scraping de données, il est recommandé de combiner différents outils selon vos besoins. L’usage de filtres et de critères de sélection permet aussi de trouver des liens ou pages qui vous intéressent, réduisant ainsi le volume de données inutiles. Pour aspirer un site complexe ou volumineux, il est recommandé d’adopter une approche structurée : planifier des crawlings progressifs, définir des priorités, et ajuster la configuration en fonction de la structure du site. Ces méthodes contribuent à améliorer la rapidité, la précision et la fiabilité du processus de scraping.

En conclusion

L’extraction de liens joue un rôle essentiel dans les études de marché. Elle permet de collecter des données pour la recherche, l’analyse SEO, la génération de leads, etc. En outre, il soutient les études de marché et la surveillance de la marque qui contribuent aux stratégies de marketing et aux efforts de conformité. Quel que soit votre secteur d’activité, vous pouvez tirer profit de l’utilisation d’extracteurs de liens. J’espère que vous trouverez les bons outils de link scraping dans cet article et que vous stimulerez votre activité à l’aide du web scraping.