Aujourd’hui, les entreprises obtiennent des informations de sources diverses, notamment des sites Web, des médias traditionnels, des journaux, des chats, des podcasts, des vidéos, etc. Utiliser des données précieuses provenant de diverses sources permet aux entreprises de prendre des décisions perspicaces et rentables. La méthode qui consiste à collecter des informations importantes sur des données provenant de différentes sources est connue comme l’extraction de données, et les outils employés pour ce faire sont connus comme les outils d’extraction de données.

L’extraction des données peut être une tâche ennuyeuse car toute organisation aura du mal à effectuer une évaluation approfondie des données collectées. C’est pourquoi les outils de collecte de données ont été développés pour rendre la méthode d’extraction des données plus fluide. En les utilisant, vous pourriez faire des hypothèses analytiques et efficaces sur une grande variété de sujets.

Cet article est un guide qui vous donnera un bon aperçu de la procédure d’extraction de données, de ses types et de ses avantages. De plus, nous vous présenterons les 10 meilleurs outils d’extraction de données que vous ne pouvez pas manquer.

Qu’est-ce que l’extraction de données ?

Introduction à l’extraction de données

C’est le processus de collecte d’informations de plusieurs sources de données pour une visualisation et une interprétation plus approfondie afin d’obtenir des données d’entreprise perspicaces ou pour le stockage dans un entrepôt de données centralisé. Les informations non structurées, semi-structurées ou structurées peuvent être obtenues de plusieurs sources. En bref, l’extraction de données est une méthode permettant d’obtenir des données d’une source et de les transférer vers une autre, qu’elle soit sur site, dans le Cloud ou une combinaison des deux.

Pour ce faire, diverses tactiques sont utilisées, dont certaines sont compliquées et comprennent souvent une saisie manuelle. L’extraction, la transformation et le chargement, ou ETL, constituent souvent la phase initiale, à moins que l’information ne soit simplement récupérée pour des besoins d’archivage. Cela signifie qu’après la collecte primaire, l’information subit presque toujours une transformation pour pouvoir être examinée ultérieurement.

Types d’extraction de données

Après avoir obtenu une compréhension fondamentale du fonctionnement de l’extraction de données, examinons les types de stratégies d’extraction de données qui sont fréquemment utilisées sur le marché. Les deux principales catégories de techniques d’extraction de données sont les techniques logiques et physiques, qui peuvent être réparties en plusieurs autres types.

1. Extraction logique des données

C’est l’approche d’extraction de données la plus utilisée. Elle peut être classée en deux sous-catégories.

Extraction complète

Ce processus apparaît fréquemment lors de la charge de début. Ainsi, toutes les données sont simplement extraites de la ressource en une seule fois. Puisque cette extraction récupère toutes les informations qui sont actuellement accessibles sur le système source, vous n’avez pas besoin de maintenir un suivi de la progression après une extraction réussie.

Extraction incrémentale

Les changements de delta dans les données sont les centres d’intérêt de cette technique. En tant que scientifique des données, vous devez d’abord appliquer des algorithmes d’extraction complexes aux sources de données et assurer le suivi des améliorations et des mises à niveau des données. Les horodatages d’extraction des données révisées sont collectés en utilisant cette technique.

2. Extraction manuelle des données

L’extraction logique peut être difficile à utiliser lorsqu’on essaie d’extraire des données de systèmes de stockage de données obsolètes. Ces données ne peuvent être obtenues que par des extractions physiques. Elle peut également être divisée en deux catégories.

Extraction en ligne

Cette technique permet d’extraire directement les données de la source de données vers l’entrepôt de données approprié. Pour fonctionner, cette approche exige un lien direct entre le système source et les outils d’extraction. Vous pouvez l’attacher au système transitoire, qui est un clone presque exact du système source mais avec des données mieux organisées, plutôt que de le connecter directement à la source.

Extraction hors ligne

Au lieu d’être extraites directement de la source originale, les données sont intentionnellement traitées en dehors de celle-ci dans cette approche. Dans cette procédure, les données sont organisées ou peuvent être structurées en utilisant des techniques d’extraction de données. Un fichier plat, un fichier de vidage ou une extraction à distance à partir des journaux des transactions de la base de données sont quelques-unes des structures de fichier qu’elle incorpore.

Avantages de l’extraction des données

Les outils d’extraction de données améliorent considérablement la précision du transfert des données car ils sont utilisés la plupart du temps sans intervention humaine, ce qui minimise la partialité et les erreurs et augmente donc la finesse des données.

“Quelles données faut-il extraire” est principalement déterminé par les outils d’extraction de données. Cela se fait tout en obtenant des données de nombreuses sources puisque les outils identifient correctement les données précises nécessaires à l’action considérée et laissent le reste pour des transferts futurs.

L’utilisation d’outils d’extraction de données permet aux organisations de choisir la taille de la collecte de données qu’elles souhaitent réaliser. Vous évitez ainsi de feuilleter manuellement des sources pour obtenir des informations, et vous pouvez simplement choisir la quantité de données à collecter et les usages auxquels elles sont destinées.

10 meilleurs outils d’extraction de données que vous devriez connaître

Il existe une grande variété d’outils d’extraction de données qui peuvent être utilisés pour collecter et surveiller les informations relatives à vos campagnes promotionnelles. Certains sont créés pour des secteurs particuliers, tandis que d’autres se concentrent sur les défis qui touchent les annonceurs, et d’autres encore ont un champ d’utilisation beaucoup plus large. Nous avons listé ci-dessous quelques-uns des meilleurs outils d’extraction de données avec leur description ainsi que certaines fonctionnalités pour vous aider à décider lequel est le plus adapté à vos besoins.

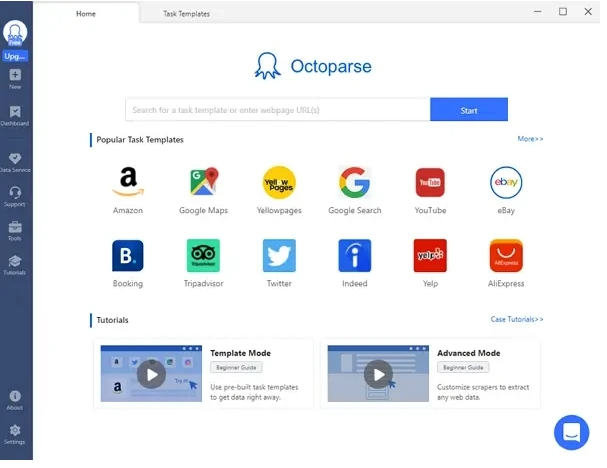

1. Octoparse

Octoparse est un scraper web robuste, qui est disponible et efficace pour les utilisateurs Mac et Windows. L’opération complète de scraping est vraiment simple et directe puisqu’elle imite les actions d’un humain.

Avec ses modèles de projets intégrés distinctifs, Octoparse permet aux utilisateurs novices de commencer facilement leurs essais de scraping. De plus, il offre gratuitement des crawls illimités, des outils Regex et Xpath pour aider à résoudre 80 % des problèmes de non-concordance des données, même lors du scraping de pages dynamiques.

Fonctionnalités principales :

- C’est un scraper web basé sur le cloud qui vous permet de récupérer rapidement et efficacement des données en ligne sans programmation.

- Vous pouvez choisir entre les options Free, Standard, Professional et Enterprise pour répondre à différents besoins.

- Il est proposé avec des modèles intégrés pour les sites Web les plus populaires, ce qui vous permet de terminer la récupération en quelques clics.

Le scraping Web en utilisant des proxies rotatifs est extrêmement facile et rapide avec Scrape.do. Toutes les fonctionnalités sont simples à utiliser et personnalisables. Vous pouvez utiliser des proxies pour atteindre le site Web cible et extraire les données brutes dont vous avez besoin en soumettant des paramètres comme l’URL, l’en-tête et le corps à l’API de Scrape.do. L’URL ciblée obtiendra tous les paramètres de requête que vous donnez à scrape.do sans modification.

Fonctionnalités principales :

- Scrape.do ne propose qu’un seul point de terminaison API

- C’est l’une des solutions de scraping web les plus abordables du marché

- Tous les abonnements comprennent une quantité illimitée de bande passante

Pour la collecte de données sur Internet, ParseHub est une application gratuite de scraper web. Le logiciel de bureau de cet utilitaire est disponible en téléchargement. Il offre plus de fonctionnalités que la majorité des autres scrapeurs, comme la possibilité de récupérer et de télécharger des fichiers et des photos, ainsi que des fichiers CSV et JSON. L’utilisation est gratuite, mais les fonctions premium sont disponibles dans les plans payants.

Fonctionnalités principales :

- Vous pouvez utiliser le service de cloud pour stocker automatiquement les données

- Obtenez des informations de cartes et de tableaux

- Accepte les pages à défilement infini

Diffbot est un autre outil permettant d’extraire des données de sites Web. Ce collecteur d’informations fait partie des meilleurs extracteurs de contenu disponibles aujourd’hui. Grâce à la fonctionnalité Analyze API, vous pouvez l’utiliser pour identifier automatiquement des sites et extraire des articles, des débats, des vidéos ou des photographies.

Fonctionnalités principales :

- Les plans commencent à 299 $/mois et une période d’essai gratuite de 14 jours est disponible.

- Vous pouvez utiliser le traitement visuel pour extraire la majorité des sites Web qui n’utilisent pas l’anglais.

- Recherche structurée pour n’afficher que les résultats pertinents.

Il s’agit d’une solution de scraping web basée sur le cloud. Vous pouvez exécuter vos propres agents en utilisant son portail en ligne et son constructeur d’agents, et vous pouvez voir et gérer les résultats. En outre, elle vous permet de publier ou d’exporter les données collectées vers des services de stockage en nuage comme Dropbox, Amazon S3 ou Microsoft Azure. L’extraction des données s’effectue sur des serveurs de collecte optimisés dans les centres de données de Mozenda. Cela permet d’utiliser les ressources locales de l’utilisateur et de se prémunir contre les interdictions d’adresses IP.

Fonctionnalités principales :

- Sans vous connecter manuellement à la console Web, vous pouvez gérer vos agents et la collecte des données.

- Free, Professional, Enterprise et High-Capacity sont les 4 formules proposées par Mozenda.

C’est l’un des meilleurs parseurs de documents. Les données peuvent être extraites des fichiers PDF et exportées vers Excel, JSON, etc. Il transforme les données de formats inaccessibles en représentations utilisables, comme des feuilles Excel. Grâce à l’utilisation de mots-clés de référence, d’une puissante reconnaissance des formes et de la technologie OCR zonale, Docparser reconnaît et extrait les données des documents Word, PDF et images.

Fonctionnalités principales :

- Il y a 5 plans disponibles pour DocParser : Gratuit, Starter, Professional, Business et Enterprise.

- Extrayez les informations nécessaires sur les factures, puis téléchargez la feuille de calcul ou intégrez-la à votre système comptable.

Pour extraire des données structurées de Google Search, les développeurs et les agences peuvent utiliser le service API SERP (page de résultats des moteurs de recherche) appelé AvesAPI. Grâce à son réseau dynamique intelligent, ce scraper Web peut facilement extraire des millions de mots clés. Cela permet d’abandonner la tâche fastidieuse consistant à examiner manuellement les résultats des SERP et à contourner le CAPTCHA.

Fonctionnalités principales :

- Accès en temps réel aux données structurées en JSON ou HTML.

- Vous pouvez essayer cet outil gratuitement. En outre, les plans payants sont tout à fait abordables.

Vous pouvez dupliquer le contenu de n’importe quelle source de données en utilisant Hevo Data, un pipeline de données sans code. Sans coder une seule ligne de code, Hevo améliore les données, les transforme en un format d’évaluation et les transfère sur l’entrepôt de données approprié. Les données sont gérées de manière sûre, fiable et sans aucune perte de données grâce à son architecture tolérante aux pannes.

Fonctionnalités principales :

- Utilisez des tableaux de bord logiques qui montrent chaque pipeline et chaque statistique de flux de données pour garder une trace de l’état du pipeline.

- Il existe trois plans : starter, gratuit et business.

Un autre outil d’extraction de données bien connu est ScrapingBee. Il affiche votre site Web comme s’il s’agissait d’un véritable navigateur, ce qui vous permet d’utiliser la version la plus récente de Chrome pour gérer des dizaines d’instances sans tête. Par conséquent, ils affirment que le traitement des navigateurs sans tête comme les autres scrapers en ligne fait perdre du temps et consomme du CPU et de la RAM.

Fonctionnalités principales :

- Il offre des opérations générales de scraping web sans être limité, telles que le scraping immobilier, le suivi des prix et l’extraction d’avis.

- Vous pouvez gratter des pages Web à partir des résultats de recherche. Les forfaits commencent à 29 $/m.

Scrapy est encore un autre outil de notre liste des meilleurs outils d’extraction de données Web. Une plateforme interactive et transparente appelée Scrapy a été créée pour collecter des données à partir de pages Web. Pour les programmeurs Python qui cherchent à créer des crawlers web multiplateformes, c’est un cadre pour le scraping web.

Fonctionnalités principales :

- Il peut être facilement étendu sans modifier le noyau car il est conçu pour être extensible.

- Cet utilitaire est entièrement gratuit.

Les outils d’extraction de données les plus performants et les plus appréciés disponibles aujourd’hui, qui peuvent être utilisés pour rationaliser le processus d’extraction, ont été examinés en détail dans cet article. En outre, il met en évidence certaines caractéristiques et certains prix de ces outils. Le choix de l’outil d’extraction de données approprié est un aspect important du processus global d’extraction de données dans toute entreprise.