Pour mieux profiter du content affiché sur Internet, on peut extraire les données à des usages différentes. Ce processus est ce qu’on appelle “Web Scraping” et l’outil utilisé est “Web Scraper“.

En général, on est habitué à copier et coller le contenu sur les pages Web si on ne sait pas comment programmer. Cette méthode sans aucune efficacité constitue évidemment un gaspillage de temps. En outre, la plupart des informations sont conservées dans un site Web sous différentes formes – mise dans un balise ou attribut HTML. C’est pourquoi nous conseillons aux non-codeurs d’utiliser un web scraper (soit outil de web scraping) capable d’extraire avec précision le contenu dont ils ont besoin. Et cet article cherche à introduire plus clairement le Web Scraper et à montrer comment créer un web scraper avec Octoparse.

Qu’est-ce que Web Scraper ?

Un Web Scraper met en service la technique de Web Scraping pour extraire un océan d’informations à partir des sites Web vers l’ordinateur local ou dans une base de données au format visuel. Avec un Web Scraper, vous serez en mesure de collecter en masse et à grande échelle des données qui désignent en effet toutes les données affichées sur les pages Web ou précisément, texte, image, vidéo, url, numéro… En un mot, tout !

A quoi servent les Web Scrapers ?

De nos jours, le web scraping est largement utilisé dans divers domaines, tels que nouvelle, blog, SEO, média sociaux, immobilier, finance, e-commerce, éducation, sport, tourisme, etc. Les objectifs de mettre en application cette technique sont également variés : la génération de leads, la comparaison de prix, la détection des changements sur un site Web, la surveillance de la concurrence, l’étude de l’opinion publique, le marché, etc.

La technique du web scraping est mise en oeuvre par des logiciels d’extraction de données (on dit aussi des outils de web scraping). Ces outils sont capables de simuler les actions humaines d’interagir avec les sites Web et donc, les utilisateurs peuvent facilement apprendre à profiter de ces outils.

Beaucoup de monde est convaincu que le web scraping peut réellement les libérer des actions répétitives et ennuyeuses de copier et coller manuellement, mais il a également l’impression que créer un web scraper est le jeu des professionnels techniques. En effet, il s’agit là d’un malentendu.

Il est facile de créer un web scraper si on a recours à un outil de web scraping et vous n’avez même pas besoin de savoir écrire un seul ligne de code. Tout ce dont vous avez à faire est de choisir le bon outil. Alors, comment choisir le bon logiciel pour construire un web scraper simple, compte contenu du grand nombre de logiciels d’extraction de données.

Quelle est la première chose qui vous vient à la tête ? Eh bien, il est préférable que le logiciel soit gratuit, facile, puissant. On vient de mener une comparaison complète et détaillée sur les cinq principaux outils populaires, je suis sûr que cela va vous donner une idée sur les critères pour choisir un bon outil.

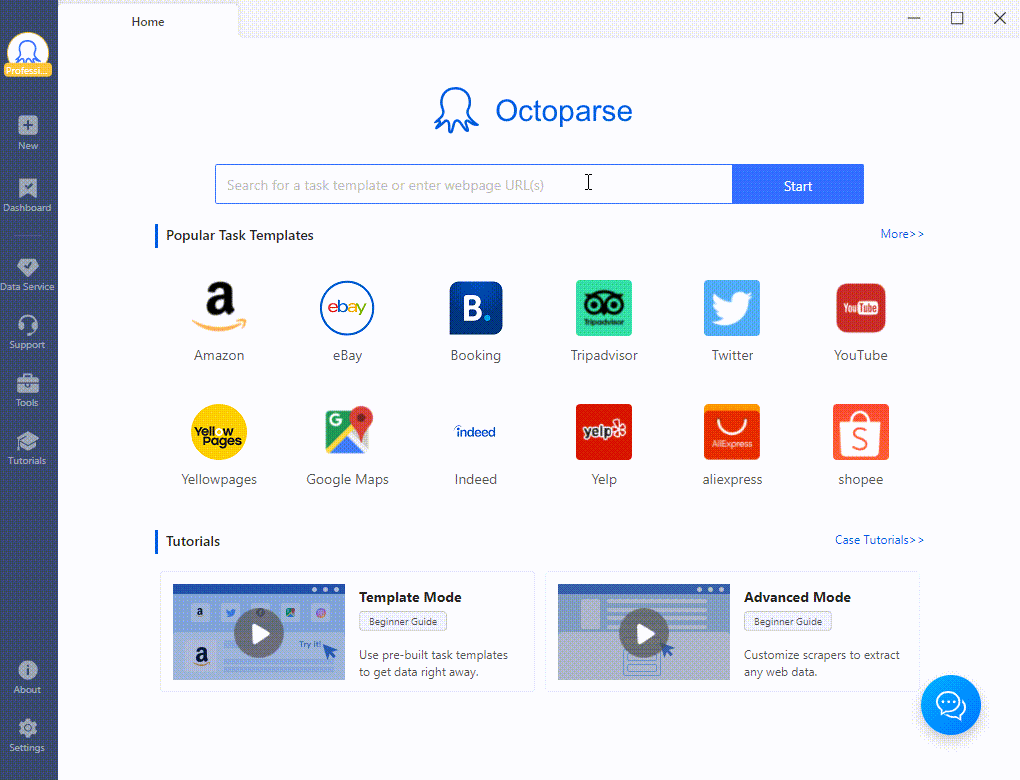

Octoparse semble un bon choix en offrant des fonctionnalités avancées pour vous aider à extraire tout le texte des documents HTML.

Comment créer un Web Scraper en dix minutes avec Octoparse ?

Dans cette partie, on va commencer par créer un web scraper avec Octoparse, ce qui va vous faire comprendre mieux qu’est-ce que Web Scraper.

Je vous invite à télécharger Octoparse et à suivre les étapes ci-dessous pour créer un Web Scraper par vous-même. Il s’agit peut-être d’un nouveau départ de votre voyage de scraping !

Étape 1 lancer Octoparse, entrer URL dans la barre vide avant de cliquer sur le bouton “Start”

Étape 2 sélectionner quelques champs de données et cliquer “Extract text of the selected element” sur le panneau de Tips

Étape 3 cliquer sur le bouton “Run” pour exécuter la tâche.

On prend pour exemple https://www.octoparse.fr/blog

Voilà un web scraper ! Cependant, à franchement dire, c’est le web scraper le plus simple.

Dans la plupart des cas, on a à créer un boucle pour récupérer toutes les données sur page présente, à configurer la pagination pour récolter les données sur plusieurs pages, à sélectionner plusieurs champs de données, à scraper plusieurs sites Web.

Pour créer des tâches plus avancées ou pour découvrir davantage sur Octoparse, un ensemble de tutoriels sont accessibles. En outre, l’équipe Octoparse a rédigé un grand nombre d’articles pour analyser plus profondément le big data, le web scraping, l’application, et beaucoup d’autres choses intéressantes relatives.