Ceux qui ont fait le web scraping recontrent probablement un des défis fréquents : blocage d’adresse IP. Le proxy IP est une bonne solution pratique largement utilisée. C’est ce que cible cet article, on va voir comment utiliser un serveur proxy dans le web scraping pour que l’extraction de données va comme sur des roulettes. En outre, on énumérera quelques outils de web scraping équipés de proxies IP à destination des non-codeurs.

Le proxy est une solution au blocage d’adresse IP

Le web scraping ou l’extraction de données web est devenu une méthode idéale pour récupérer des données depuis des pages Web. De nombreux utilisateurs et entreprises en profitent pour améliorer l’efficacité et créer de la croissance.

Cependant, le web scraping n’est pas aussi bienvenu pour les sites web car il peut surcharger les serveurs des sites Web, ce qui peut potentiellement faire tomber les sites dans le pire des cas. Par conséquent, les propriétaires de sites Web appliquent des techniques de anti-scraping pour lutter contre ce phénomène. Parmi ces méthodes de anti-scraping, le moyen le plus courant est de limiter le taux d’accès d’une seule IP. Si un web scraper envoie trop de requêtes dans un temps très court en utilisant une seule adresse IP, ce IP sera facilement détecté, et va être bloqué par le site. Pour réduire les risques de blocage, il nous faut éviter de récupérer un site Web avec une seule adresse IP.

Comment fonctionne un serveur proxy ?

Lorsqu’un ordinateur se connecte à l’internet, il utilise une adresse IP. Celle-ci, similaire à l’adresse géographique de votre maison, peut indiquer aux données reçues où aller et marquer les données sortantes avec une adresse de retour pour que d’autres appareils puissent les authentifier. Un serveur proxy est essentiellement un ordinateur sur l’Internet qui possède sa propre adresse IP. Toutes les requêtes adressées à l’Internet sont d’abord transmises au serveur proxy, ce dernier évalue les demandes et puis les transmet à l’Internet. De même, les réponses reviennent au serveur proxy, puis à l’utilisateur. De ce fait, les serveurs proxy offrent différents types de fonctionnalités, de sécurité et de confidentialité en fonction de votre cas d’utilisation, de vos besoins ou de la politique de votre entreprise.

L’utilité de proxies au cours du web scraping

Les proxies sont utiles pour diverses raisons, dont les plus importantes :

Gestion de blocage

Les proxies permettent de contourner ces blocages en utilisant différentes adresses IP pour effectuer les requêtes. En changeant fréquemment d’adresses IP, les proxies rendent plus difficile pour un site web de détecter qu’il s’agit d’un scraper.

Anonymat

Les proxies permettent de cacher votre adresse IP réelle et d’utiliser une adresse IP différente pour accéder à un site web. Cela permet de rester anonyme et d’éviter d’être bloqué par les sites web qui limitent le nombre de requêtes provenant d’une même adresse IP.

Localisation

Les proxies peuvent être utilisés pour simuler une localisation différente de celle de l’utilisateur. Cela peut être utile pour accéder à des sites web qui sont géo-restreints.

Performance

En utilisant des proxies, il est possible de répartir les requêtes sur plusieurs adresses IP, ce qui peut améliorer les performances du web scraping en réduisant le temps d’attente entre les requêtes.

Outils de web scraping équipés de proxy

Pour les non-codeurs, la meilleure façon est de choisir des outils de web scraping déjà équipés de proxies, comme Octoparse. Ces outils permettent d’ajouter des proxies IP à votre disposition ou de bénéficier les ressources de proxy IP intégrées

Parmi les outils de scraping les plus populaires, on compte Octoparse, Mozenda, Parsehub et Screen Scraper.

Octoparse

Octoparse est un outil de web scraping puissant et gratuit, capable de récupérer presque tous les sites Web.

Son extraction de données basée sur le Cloud fonctionne avec un grand pool d’adresses IP de Cloud qui minimise les risques de blocage et protège vos adresses IP locales. Avec plusieurs pools d’adresses IP par pays, vous pouvez extraire efficacement des sites Web qui ne sont accessibles qu’aux adresses IP d’une région ou d’un pays spécifique.

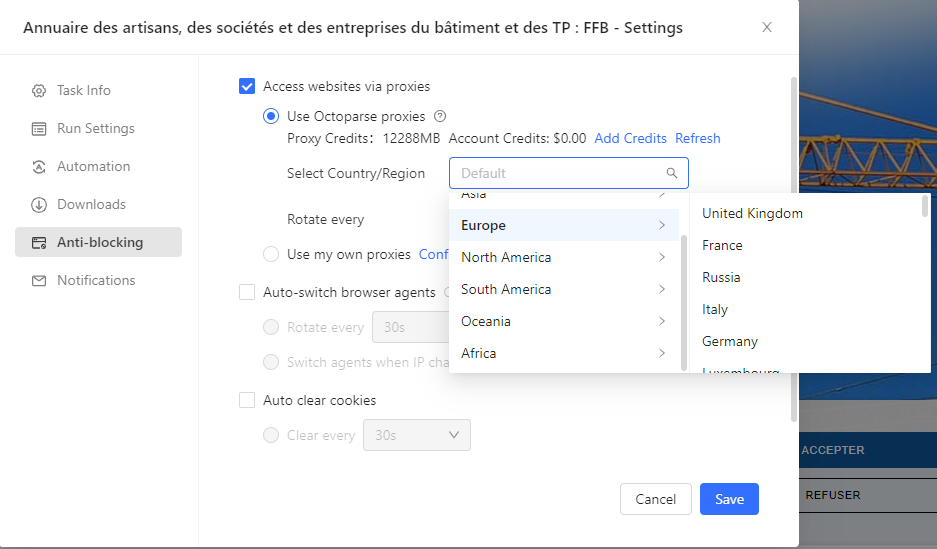

En outre, vous pouvez ajouter vos propres proxies ou utiliser les proxies résidentiels intégrés d’Octoparse. Vous pouvez choisir le pays ou la région, et définir le délai de rotation de IP.

Cela coûte 3$/G proxies. Assurez-vous d’avoir suffisamment de crédits proxy pour utiliser cette fonction. Les crédits de compte affichés sur la page peuvent être utilisés pour l’achat de proxies. Vous pouvez simplement recharger vos crédits en cliquant sur le bouton Ajouter des crédits. 1G de proxies peut généralement récupérer 500 pages web.

Mozenda

Mozenda est également un scraper de données de bureau facile à utiliser. Il propose aux utilisateurs des proxies de géolocalisation et des proxies personnalisés. Les proxies de géolocalisation vous permettent de faire passer le trafic de votre crawler par une autre partie du monde afin d’accéder à des informations spécifiques à une région. Lorsque la géolocalisation standard ne répond pas aux exigences de votre projet, vous pouvez vous connecter à des proxys d’un fournisseur tiers via des proxys personnalisés.

Parsehub

Parsehub est un outil facile à apprendre, visuel, pour collecter des données sur le Web, qui permet également le “cloud scraping” et la rotation d’IP. Après avoir activé la rotation d’IP pour vos projets, les proxies utilisés pour exécuter votre projet proviennent de nombreux pays différents. En outre, vous avez la possibilité d’ajouter votre propre liste de serveurs mandataires personnalisés à ParseHub dans le cadre de la fonction de rotation d’adresses IP si vous souhaitez accéder à un site Web à partir d’un pays particulier ou si vous préférez utiliser vos propres serveurs mandataires au lieu de ceux fournis pour la rotation d’adresses IP.

Apify

Apify est une plateforme de web scraping et d’automatisation pour la collecte de données. Il offre non seulement un service de collecte de données, mais aussi un service de proxy réduisant le blocage de votre web scraping. Apify Proxy donne accès à la fois aux adresses IP résidentielles et à celles des centres de données. Les adresses IP des centres de données sont rapides et bon marché mais peuvent être bloquées par les sites Web cibles. Les adresses IP résidentielles sont plus chères et plus difficiles à bloquer.

Utilisation pratique de proxy dans Octoparse

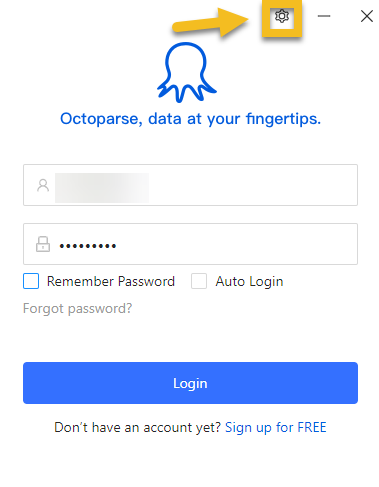

Utiliser un proxy pour se connecter sur Octoparse

Aller dans les paramètres sur le panneau de connexion et puis entrer les informations de proxies selon les instructions. Vous pouvez faire un test pour voir si la connexion est bonne avant de confirmer la configuration.

Rotation des serveurs proxy externes pour contrer le blocage des adresses IP

Les IP d’Octoparse Cloud sont des IP de centre de données, n’excluant pas la possibilité d’être bloqués. Si un site web prend un blocage de IP strict, vous pouvez ajouter vos propres proxies IP ou utiliser les proxies résidentiels intégrés d’Octoparse.

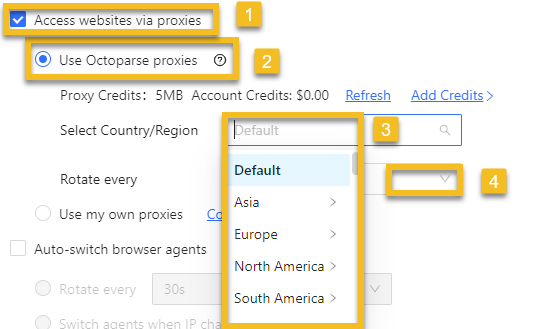

Ouvrir la tâche pour laquelle vous souhaitez mettre en place des proxys et puis aller aux paramètres de la tâche. Cocher Access websites via proxies, cliquer sur Use Octoparse proxies, sélectionner Defaut ou pays/région pour l’adresse IP (Défaut signifie utiliser des IP de pays aléatoires), définir le délai de rotation et à la fin, cliquer sur le bouton Enregistrer dans le coin supérieur gauche de l’interface pour enregistrer vos paramètres.

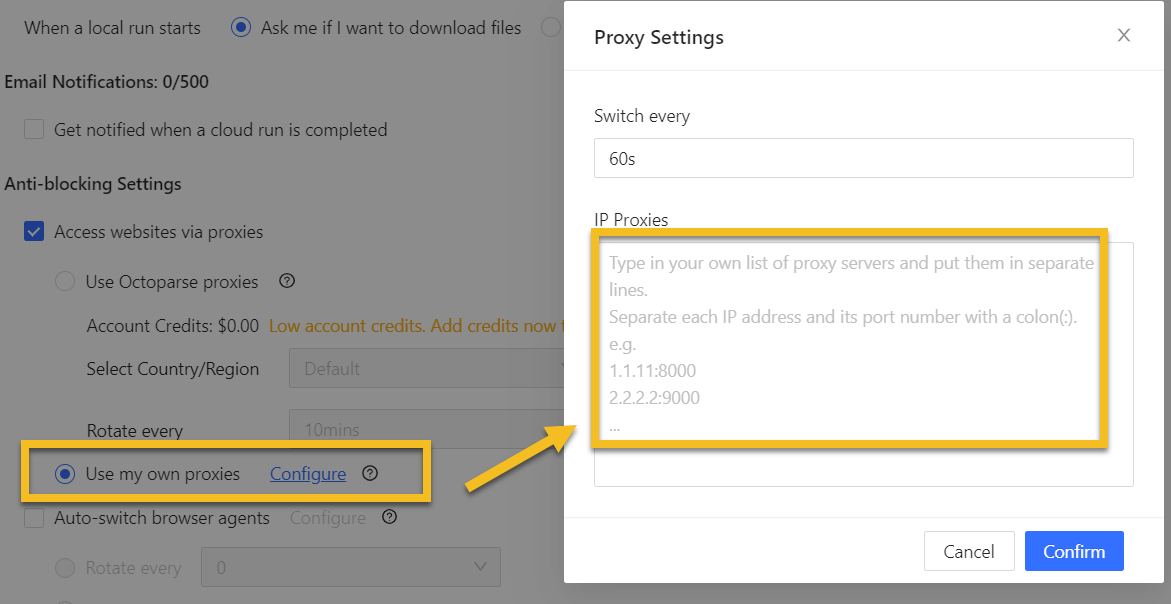

Au cas où vous préférez utiliser vos propres proxies, cochez Use my own proxies et puis entrer les proxies. Mais attention, vos propres proxys IP ne peuvent être appliqués que dans les exécutions locales.

En conclusion

Vous devriez maintenant avoir une compréhension basique de ce qu’est un serveur proxy et comment il peut être utilisé pour le web scraping. Même si le proxy rend le web scraping plus efficace, il est également important de suivre des conseils utiles pour éviter le blocage. Par exemple, il faut contrôler la vitesse de scraping et éviter de surcharger les sites. Ne pas dépasser les limites des sites Web et ne pas rompre l’équilibre vous aidera à obtenir les données continuellement.